有效利他主义的问题不仅仅是山姆·班克曼-弗里德 - 彭博社

Ellen Huet

插图:Sophi Gullbrants for Bloomberg Businessweek

插图:Sophi Gullbrants for Bloomberg Businessweek

Sonia Joseph在14岁时第一次阅读了哈利·波特与理性方法,这是一部重新想象男孩巫师为严格经验主义者的超级流行的同人小说。这位理性的波特用科学方法测试他的教授的咒语,嘲笑他发现的任何不一致之处,并在他12岁之前解决了巫师界的所有问题。Joseph说:“我喜欢它”,她在十几岁时读了HPMOR四次。她是一个神经非典型的、雄心勃勃的印度裔美国人,在她的马萨诸塞州郊区高中感到格格不入。她说,这个故事“非常吸引聪明的局外人。”

对同人小说作者 埃利泽·尤德科夫斯基的其他作品的搜索为Joseph打开了更多的大门。自2000年代初以来,尤德科夫斯基一直主张敌对人工智能可能在几十年内摧毁人类。这一信念使他成为一个智力上的伯父,在一个自称为理性主义者的群体中,他们致力于保持他们的思维不偏不倚,即使结论令人恐惧。Joseph对理性主义的兴趣的萌芽也使她走向了有效利他主义,这是一种相关的道德哲学,因其与被辱的加密前亿万富翁山姆·班克曼-弗里德的关联而臭名昭著。有效利他主义的核心是强调利用理性思维对世界产生最大效益的积极影响。这些不同但有重叠的群体在在线论坛中发展起来,关于人工智能危险的帖子变得普遍。但他们也聚集在旧金山湾区,在那里他们开始勾勒出一个名为AI安全的研究领域,这是一项使机器更不可能杀死我们所有人的努力。

约瑟夫摄影师:亚历克斯·布鲁因和乔迪·赫茨,为彭博商业周刊拍摄约瑟夫在2019年获得神经科学学士学位后不久搬到旧金山湾区从事人工智能研究。在那里,她意识到在网上看起来如此庞大的社交圈在现实中却更为紧密。许多理性主义者和有效利他主义者,自称为EA,共同工作,相互投资,住在共同的房子里,主要与彼此社交,有时还处于多元关系的网络中。在整个社区中,几乎每个人都在庆祝某种方式的非传统。约瑟夫觉得这一切都很自由和令人兴奋,就像来到了一个现实版的理性主义霍格沃茨。她和她的同龄人一起致力于解决她认为最迷人的问题,目标是防止人类灭绝。

约瑟夫摄影师:亚历克斯·布鲁因和乔迪·赫茨,为彭博商业周刊拍摄约瑟夫在2019年获得神经科学学士学位后不久搬到旧金山湾区从事人工智能研究。在那里,她意识到在网上看起来如此庞大的社交圈在现实中却更为紧密。许多理性主义者和有效利他主义者,自称为EA,共同工作,相互投资,住在共同的房子里,主要与彼此社交,有时还处于多元关系的网络中。在整个社区中,几乎每个人都在庆祝某种方式的非传统。约瑟夫觉得这一切都很自由和令人兴奋,就像来到了一个现实版的理性主义霍格沃茨。她和她的同龄人一起致力于解决她认为最迷人的问题,目标是防止人类灭绝。

与此同时,她开始感受到一些奇怪的氛围。一个理性主义男性把她介绍给另一个人,称其为“完美的理性主义诱饵”——rat指的是理性主义者。她听说了涉及该领域男性领导人的性行为不端的故事,但当她询问周围的人时,她的同龄人都把这些指控视为微不足道的性格缺陷,不足以与AI启示录的威胁相提并论。最终,她开始与社区中的一名AI研究人员约会。她声称他对她实施了性行为不端,并向旧金山警方报案。(像她这样的许多女性一样,她要求不透露该男子的姓名,以免遭到可能的报复。)她的指控使社区产生了分歧,她说,人们质疑她的心理健康,试图抹黑她。最终,她搬到了加拿大,在那里她继续从事AI工作,并努力营造一个更健康的研究环境。

“在理想的世界中,社区本应就性侵政策和教育进行认真讨论:‘我们有哪些盲点?这是怎么发生的?我们如何设计机制来防止这种事情再次发生?’”她说。“我对社区如何通过这种非常扭曲、厌恶女性的视角看待我感到失望。”

在硅谷,理性主义者、有效利他主义者和人工智能安全研究人员之间存在一个深具影响力的亚文化。尽管其边界模糊不清,但数以百计甚至数千名成员都相信他们需要拼命工作,或者至少投入大量资金,以阻止人工智能对我们发动“终结者”式的袭击。该运动的领导者得到了一些科技界最富有和最有权势的人士的支持,包括埃隆·马斯克、彼得·蒂尔和以太坊创始人维塔利克·布特林。其理念吸引了硅谷典型的信徒和厚颜无耻的机会主义者。直到最近,其最慷慨的支持者是Bankman-Fried,在他的事业崩溃前,他在相关事业上投入了近6亿美元,然后将有效利他主义视为一种逃避。 有效利他主义,一旦他的事业崩溃,就将其视为一种逃避。 一旦他的事业崩溃,就将其视为一种逃避。。

Bankman-Fried摄影师:Lam Yik/BloombergBankman-Fried的崩溃揭示了社区的缺陷,但他远非唯一被指控的不良行为者。使这一亚文化对聪明外人如此具有吸引力的封闭性和共同目标的结合也使其成为骗子、性侵者和狂妄自大者的猎场。通过硅谷弥赛亚情结的熟悉视角过滤对使人工智能更好、更安全的合法愿望,有可能因为关联而玷污整个项目。

Bankman-Fried摄影师:Lam Yik/BloombergBankman-Fried的崩溃揭示了社区的缺陷,但他远非唯一被指控的不良行为者。使这一亚文化对聪明外人如此具有吸引力的封闭性和共同目标的结合也使其成为骗子、性侵者和狂妄自大者的猎场。通过硅谷弥赛亚情结的熟悉视角过滤对使人工智能更好、更安全的合法愿望,有可能因为关联而玷污整个项目。

根本的意识形态崇尚极端:追求理性真理高于一切,捐赠最多的钱并出于最重要的原因做最大的善事。这种思维方式可能具有吸引力的清晰度,但也可能为破坏性或可鄙的行为提供掩护。这些领域中的八名女性声称普遍存在性骚扰,包括滥用和骚扰,他们说这种行为经常被淡化。即使是怀有纯洁意图的人,信徒们说,有效利他主义和理性主义意识形态可能会放大那些倾向于末日思维的人的痛苦,导致一些人产生精神崩溃。

这些裂缝具有全球性后果。社区的联系和资源使其成员在人工智能的发展上拥有超出比例的影响力,这是当今科技行业最着迷的对象,也是价值无数亿的极其强大的工具。信徒们试图让人工智能成为一种善的力量,但幻灭的成员说,他们那个志同道合的社区正在被那些似乎不知道如何做人的人利用和滥用。“即使坏的人工智能结果很可能会发生,”约瑟夫说,“将其用作侵蚀人权的借口是对我们正在为之奋斗的东西的不尊重。”

这种过于迂腐的社区的边界可能很难定义。一些理性主义者不认为自己是有效利他主义者,反之亦然。许多人稍微偏离特定正统信仰,用诸如“后理性主义者”或“EA相关”的术语掩饰他们的确切信仰。然而,有两件事是清楚的:在过去的十年里,有效利他主义已经成为一些边缘理性主义思想的主流、公开的代表,特别是对人工智能安全的迫切需求;整个事情始于尤德科夫斯基。

1979年出生于芝加哥的尤德科夫斯基(Yudkowsky)在青少年时期放弃了摩登正统犹太教,成为了一名无神论者。他没有完成高中学业,但在十几岁时开始对“奇点”这一概念产生了浓厚兴趣,奇点是指技术进步将不可避免地导致超人类智能的那一刻。他在2000年代开始认真地撰写有关人工智能的文章,这时已经有了HAL 9000、天网和黑客帝国等作品进入公众视野,但他的作品量却引人注目。在数年里,他每天都发表简洁的博客文章,主张研究人员应尽一切努力确保人工智能与人类价值“对齐”。为此,他在加利福尼亚州伯克利创建了 机器智能研究所(MIRI),最初得到了来自蒂尔(Thiel)和Skype联合创始人扬·塔林(Jaan Tallinn)的资助。

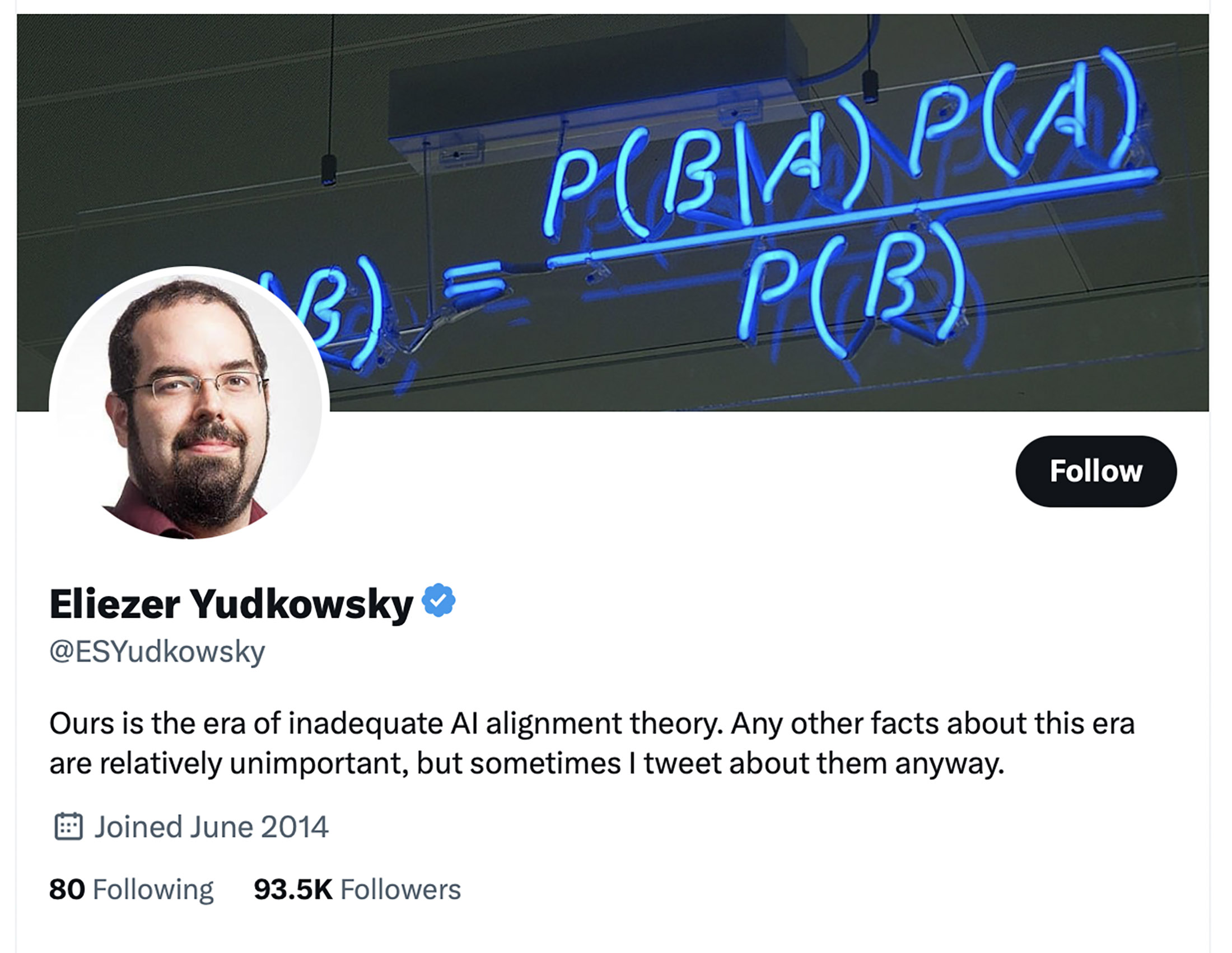

尤德科夫斯基的Twitter个人资料。来源:@ESYudkowsky/Twitter尤德科夫斯基的想法最初并没有吸引很多追随者。但他擅长营销。2009年,他创建了一个名为LessWrong的在线论坛,这个论坛发展成了一个理性主义辩论和人工智能思想实验的中心。到了2010年,尤德科夫斯基在fanfiction.net上开始连载HPMOR。这部作品的许多章节引导读者前往LessWrong上关于理性主义原则的帖子,一些章节还请求捐款给伯克利的应用理性中心(CFAR),这是一个与尤德科夫斯基有关的机构。 HPMOR“对于神经非典型人群、喜欢幻想的人和寻找社群的人来说,是一个令人难以置信的招募工具,”作家雅克琳·布里克(Jacqueline Bryk)说道,她自己也是这三个群体的成员。

尤德科夫斯基的Twitter个人资料。来源:@ESYudkowsky/Twitter尤德科夫斯基的想法最初并没有吸引很多追随者。但他擅长营销。2009年,他创建了一个名为LessWrong的在线论坛,这个论坛发展成了一个理性主义辩论和人工智能思想实验的中心。到了2010年,尤德科夫斯基在fanfiction.net上开始连载HPMOR。这部作品的许多章节引导读者前往LessWrong上关于理性主义原则的帖子,一些章节还请求捐款给伯克利的应用理性中心(CFAR),这是一个与尤德科夫斯基有关的机构。 HPMOR“对于神经非典型人群、喜欢幻想的人和寻找社群的人来说,是一个令人难以置信的招募工具,”作家雅克琳·布里克(Jacqueline Bryk)说道,她自己也是这三个群体的成员。

同时,有效利他主义也在同步发展。它起源于哲学家彼得·辛格,他认为能够拯救生命的人应该尽可能拯救更多生命。简而言之,把你本来可能捐给歌剧院的钱投入到抗疟疾蚊帐中。到了2010年代初期,像GiveWell这样的EA组织开始倡导基于研究的、可量化的慈善选择。许多有效利他主义者也转为素食主义者,并研究减少动物痛苦的最廉价方式。在它们的核心,理性主义和有效利他主义共享一个信念,即数学可以帮助回答关于是非的棘手问题。2013年,仍然是理性主义圈边缘人物的蒂尔在一年一度的EA峰会上发表了一场主题演讲,该峰会在旧金山湾区的一个理性主义团体房屋举办。

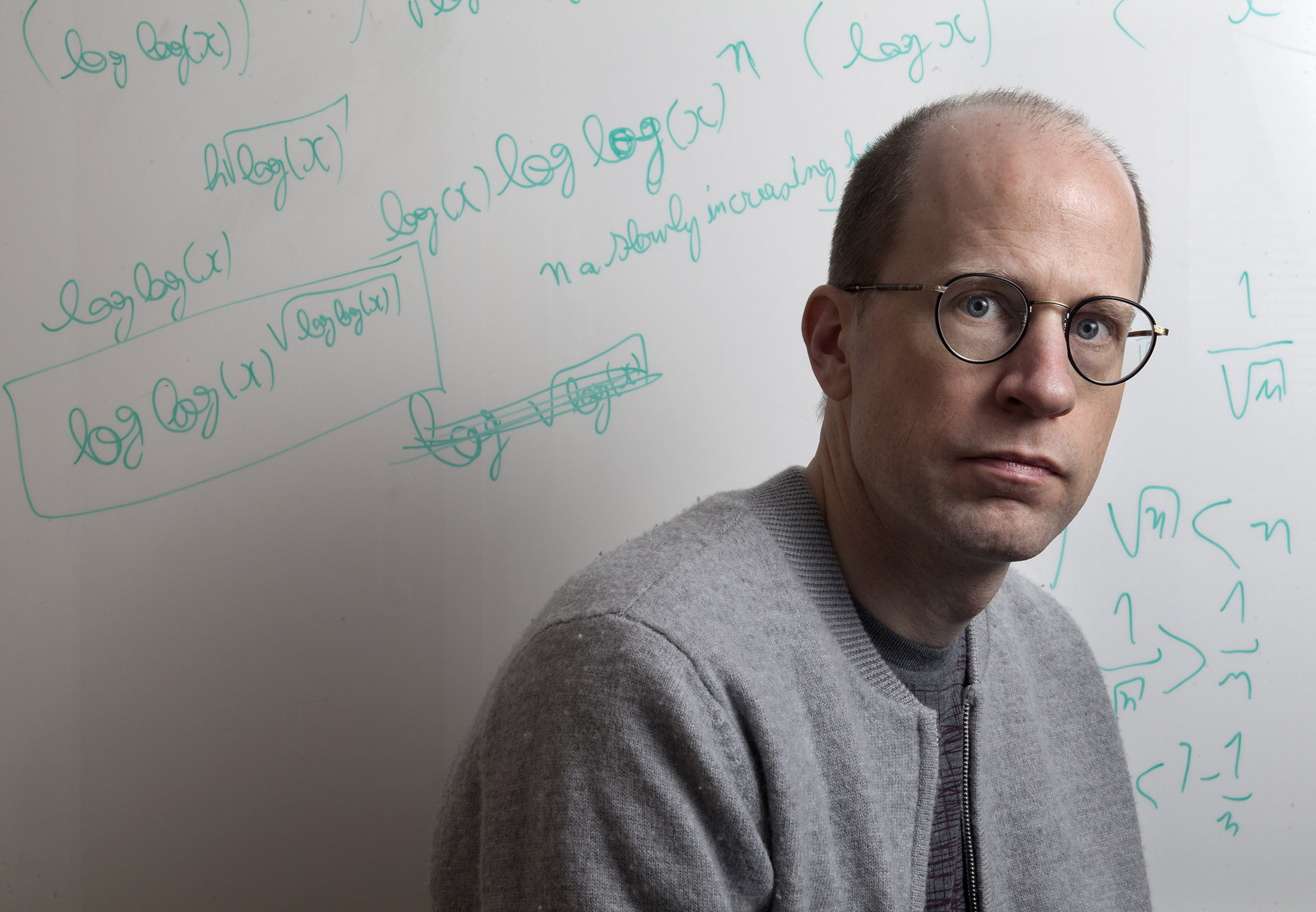

到了2014年,机器人启示录的想法赢得了更多信徒。哲学家尼克·博斯特罗姆,自上世纪90年代起就认识尤德科夫斯基,出版了畅销书超级智能,将人类比作玩弄炸弹的小孩。他写道:“我们几乎不知道爆炸将何时发生,尽管如果我们把设备靠近耳朵,就能听到微弱的滴答声。” 史蒂芬·霍金、比尔·盖茨和埃隆·马斯克都在警告。马斯克在2014年的麻省理工学院研讨会上说:“通过人工智能,我们正在召唤恶魔。” 第二年,他共同创立了OpenAI,一个旨在使人工智能对人类安全的非营利组织。80位知名科学家、学者和行业专家在波多黎各举行了一场闭门会议讨论风险,然后签署了一封警告信。

Bostrom摄影师:汤姆·皮尔斯顿/盖蒂图片社逐渐地,理性主义者、有效利他主义者和人工智能安全研究人员的世界开始融合。有效利他主义者提出了“长期主义”这个词,意味着如果所有生命都同等重要,那么最好是拯救未来数万亿个潜在生命,而不是当今地球上的数十亿生命。因此,放弃疟疾蚊帐,集中精力应对核扩散、未来大流行病以及,没错,失控的人工智能等灾难。

Bostrom摄影师:汤姆·皮尔斯顿/盖蒂图片社逐渐地,理性主义者、有效利他主义者和人工智能安全研究人员的世界开始融合。有效利他主义者提出了“长期主义”这个词,意味着如果所有生命都同等重要,那么最好是拯救未来数万亿个潜在生命,而不是当今地球上的数十亿生命。因此,放弃疟疾蚊帐,集中精力应对核扩散、未来大流行病以及,没错,失控的人工智能等灾难。

几年来,这个想法成为硅谷辩论中不可避免的话题。在这个场景中,有效利他主义拥有迄今为止最主流的声望和亿万富豪捐助者支持,因此这种转变意味着真正的资金和认可。2016年,时任联合首席执行官的 开放慈善,由Facebook联合创始人达斯汀·莫斯科维茨资助的有效利他主义非营利组织,写了一篇博客文章,解释了他新的热情,希望防止人工智能末日。在接下来的几年里,开放慈善对长期主义事业的资助从2015年的200万美元增加到2021年的1亿美元以上。

2019年,开放慈善向MIRI捐赠了770万美元,而比特币创始人维塔利克·布特林捐赠了价值500万美元的现金和加密货币。但其他个人捐助者很快就被长期利他主义者Bankman-Fried超越,他是一位长期的有效利他主义者,创建了加密交易平台FTX,并在2021年成为亿万富翁。在Bankman-Fried去年财富蒸发之前,他召集了一群领先的有效利他主义者来管理他每年1亿美元的长期主义事业未来基金。据《纽约客》报道,在该基金的伯克利办公室,水冷却器旁的闲聊包括关于人工智能接管会在多久以后发生以及发生的可能性有多大的问题,或者用该群体的行话来说,“你的时间表是什么?”和“你的p(毁灭)是多少?”

有效利他主义转向了人工智能安全领域。一位曾是该社区成员的人士说:“存在这种压力,如果你足够聪明或者足够注重定量分析,你就会放下手头的一切去从事人工智能安全工作。”80,000小时,一个在有效利他主义者中具有影响力的职业建议播客,开始推荐该领域的工作优先于其他一切。但社区也开始出现分裂。OpenAI曾作为一个非营利组织推出,2019年宣布转型为一家营利企业,并获得了来自微软公司的10亿美元投资。两年后,几位OpenAI高管脱离出来,成立了自己的研究公司Anthropic。他们声称,OpenAI实际上正在加速一种可能无法控制的人工智能的到来,因此Anthropic将继续努力确保做对。Bankman-Fried在去年初投资了5.8亿美元给Anthropic。

对于那些真诚担心人工智能启示录的研究人员来说,这场日益激烈的争执揭示了一个令人不安的问题,回响着曼哈顿计划的阴影。通过研究人工智能,他们是在保护人类的未来吗?还是,尽管怀着最好的意图,他们正在让事情变得更糟?

插图:Sophi Gullbrants为彭博商业周刊绘制随着有效利他主义的流行,对其哲学的批评也日益增加,特别是“赚钱以捐赠”的理念,即像班克曼-弗里德这样的人应该尽一切努力赚很多钱,以便捐赠。为了积累他的数十亿财富,班克曼-弗里德据称欺诈了他的客户,批评者称他的失败表明有效利他主义容易陷入一种让目的正当化非法手段的狭隘视野。然而,在有效利他主义者中,最显著的批评更为微妙:生活在这种思想的逻辑极端是不切实际的,也是一种悲惨的处境。

插图:Sophi Gullbrants为彭博商业周刊绘制随着有效利他主义的流行,对其哲学的批评也日益增加,特别是“赚钱以捐赠”的理念,即像班克曼-弗里德这样的人应该尽一切努力赚很多钱,以便捐赠。为了积累他的数十亿财富,班克曼-弗里德据称欺诈了他的客户,批评者称他的失败表明有效利他主义容易陷入一种让目的正当化非法手段的狭隘视野。然而,在有效利他主义者中,最显著的批评更为微妙:生活在这种思想的逻辑极端是不切实际的,也是一种悲惨的处境。

有效利他主义者专注于优化他们的影响力,甚至可以说是到了一种打倒一个想法的标准方式就是称其为“次优”。然而,最大化善行是一种固执的原则。(班克曼-弗里德在80,000 Hours上的出现中说:“只做得好没有理由停下来。”)如果捐赠收入的10%是好的,那么给出更多逻辑上更好。将这种完美主义推向极端可能会让人陷入瘫痪。一位著名的有效利他主义者朱莉娅·怀斯描述了她每次考虑购买冰淇淋时面临的心理挣扎,知道这笔钱可以用来给海外某人接种疫苗。出于类似原因,她在是否可以为自己生孩子上苦恼不已;当她的父亲担心她似乎不快乐时,她告诉他:“我的幸福不是重点。”

Wise自那时起修改了她的冰淇淋预算并成为了一名母亲,但许多其他EA仍然陷入了一些人所谓的“苦难陷阱”。一位前EA发推文说,他的内心声音“会自动将我花的所有钱(比如晚餐)转换为一个‘死亡计数器’,期望我如果把它捐给慈善机构,就可以拯救的生命的一部分。”另一位发推文说,“EA意识形态导致信徒将自己视为行动符合EA意识形态的小机器,这导致‘压制你人性中重要的部分’。简而言之:EA经常很难兼顾,因为咀嚼使行走变得不够理想。”

该运动对AI安全的优先考虑也引起了批评者的关注,他们认为这种全有或全无的方法是一种逃避,一种避免与更可解决的问题接触,而更倾向于技术行业利益的方式。“如果你真的觉得AI很酷,相信有必要相信你必须为之工作来拯救世界吧?”经常发表对有效利他主义进行尖锐批评的AI伦理学家Timnit Gebru问道。“你不必为未解决饥饿问题感到内疚。”

即使领先的EA对转向AI也存在疑虑。Leverage Research首席运营官、前有效利他主义中心首席执行官Larissa Hesketh-Rowe表示,她从未清楚某人如何能确定他们的工作使AI更安全。当社区中地位较高的人说AI风险是一个重要的研究领域时,其他人就会推迟,她说。“没有人会明确地这样想,但你会被吸引赞同那些人,如果你赞同他们,你就会成为酷孩子团体中的一员,”她说。“如果你不明白,那么你就不够聪明,或者你不够好。”Hesketh-Rowe于2019年离职,此后对EA感到幻灭,并认为社区陷入了一种羊群心理状态。

Hesketh-Rowe摄影师:泰勒·丹·汉森,彭博商业周刊在理性社区的极端派别中,人工智能研究人员相信他们与启示相关的压力正在导致精神崩溃。MIRI员工杰西卡·泰勒有时的工作内容包括“想象极端的人工智能折磨场景”,她在一篇LessWrong的帖子中这样描述——人工智能可能对人们造成的最严重的痛苦。她说,在工作中,她和一小队研究人员相信“我们可能会创造上帝,但我们可能会出错并摧毁一切。” 2017年,她因妄想自己“本质上是邪恶的”并“用我的恶魔力量摧毁了世界的重要部分”而住院三周,她在帖子中写道。尽管她承认出于治疗目的服用迷幻药物,但她也将妄想归因于工作中噩梦场景与现实生活的模糊。她写道:“在普通患者中,幻想成为魔鬼被视为夸大狂”,“在这里,这个想法自然而然地源自我的日常社交环境,并且是我精神崩溃的核心。”

Hesketh-Rowe摄影师:泰勒·丹·汉森,彭博商业周刊在理性社区的极端派别中,人工智能研究人员相信他们与启示相关的压力正在导致精神崩溃。MIRI员工杰西卡·泰勒有时的工作内容包括“想象极端的人工智能折磨场景”,她在一篇LessWrong的帖子中这样描述——人工智能可能对人们造成的最严重的痛苦。她说,在工作中,她和一小队研究人员相信“我们可能会创造上帝,但我们可能会出错并摧毁一切。” 2017年,她因妄想自己“本质上是邪恶的”并“用我的恶魔力量摧毁了世界的重要部分”而住院三周,她在帖子中写道。尽管她承认出于治疗目的服用迷幻药物,但她也将妄想归因于工作中噩梦场景与现实生活的模糊。她写道:“在普通患者中,幻想成为魔鬼被视为夸大狂”,“在这里,这个想法自然而然地源自我的日常社交环境,并且是我精神崩溃的核心。”

泰勒的经历并不是个案。它概括了一些理性主义者的文化主题,他们经常聚集在MIRI或CFAR员工周围,共同生活,并痴迷于推动社会规范、真相甚至意识思维的边界。他们称外部人为普通人或NPC,即非玩家角色,就像视频游戏中只说几句话并且不在情节中发挥作用的小镇居民。在家庭聚会上,他们花时间“调试”彼此,进行一种据称会产生更理性思维的对抗式审问风格。有时,为了进一步探索,他们尝试用迷幻药物进行实验,并尝试“越狱”他们的思维,打开他们的意识,使他们更有影响力或“主体性”。泰勒圈子中有几个人经历了类似的精神崩溃。其中一人于2018年自杀,另一人于2021年去世。

社区的一些现任和前任成员表示,其动态可能“类似邪教”。一些内部人士称这种对AI启示录的狂热程度为一种世俗宗教;一位前理性主义者称其为无神论者的教堂。它提供了一个更高的道德目的,人们可以将自己的生活奉献给它,以及一个强调末日审判的更高权力。在这个团体内部,有一种无言的感觉,认为自己是足够聪明以看到真相并拯救世界的被选之民,“在宇宙中具有重要意义,”前理性主义者袁乔楚说。

袁乔楚在2013年开始与理性主义者交往,当时他是加州大学伯克利分校的数学博士候选人。一旦他真诚地开始考虑AI可能在20年内消灭人类的想法,他就辍学了,放弃了退休规划的想法,并远离了那些没有将每一个清醒时刻奉献给避免全球毁灭的老朋友。“如果你能说服他们这样做可以帮助阻止世界末日,你就可以真正操纵人们做各种疯狂的事情,”他说。“一旦你进入那种思维模式,它会严重扭曲你关心其他事情的能力。”

“每个人都相信我,但他们的相信还不够。你需要那些非常关心虐待问题的人”

当涉及到社区中对女性的虐待时,这种无法关心的现象最为明显,因为投机分子利用即将到来的末日前景来为滥用行为开脱。根据对社区各层次的八名女性的采访,理性主义者、有效利他主义者和AI安全研究人员的亚文化中,性骚扰和虐待是令人痛心的普遍现象。许多年轻、雄心勃勃的女性描述了类似的轨迹:她们最初被这些理念吸引,然后沉浸在社交场景中。通常这意味着参加有效利他主义者或理性主义者团体的聚会,或者被加入到充满术语的Facebook Messenger聊天群中,与数百名志同道合的人一起。

这八位女性表示,场景中充斥着随意的厌恶女性主义。从低端来看,理性主义者附近的作家Bryk说,一位知名的理性主义者曾经轻蔑地告诉她,她是一个“五岁的小孩,身体却是20岁的热辣美女”。与年龄大得多的男性建立关系很常见,多元恋爱也很普遍。这两者本质上并不有害,但几位女性表示,这些规范成为帮助有影响力的年长男性获得更多伴侣的工具。现年20多岁的谷歌Brain的AI研究员Keerthana Gopalakrishnan参加了EA聚会,被已婚男性调戏,并被他们讲述单一配偶制已经过时,非单一配偶制更为进化的观点。“如果你是一个相貌尚可的女性进入EA社区,你会收到大量的性请求加入多人关系,通常来自于有影响力或直接资助该运动的多元和已婚男性”,她在一个关于她经历的EA论坛上写道。她的帖子遭到了强烈的踩,最终她将其删除了。她写道。

Yudkowsky的书。来源:Eliezer Yudkowsky社区的指导原则可能被用来为这种行为辩护。其中许多人认为,理性导致对世界的优越结论,并使NPC的道德准则变得过时。前往旧金山湾区追求人工智能职业的女性Sonia Joseph在22岁时被鼓励与理性主义领域的一位40多岁的初创企业创始人共进晚餐,因为他与Peter Thiel有密切联系。在晚餐上,这位男士吹嘘说Yudkowsky以他为原型塑造了一个核心《HPMOR》教授。Joseph说,他还辩称,一个12岁的女孩与成年男性发生性关系是正常的,这种关系是向年轻一代传授知识的一种高尚方式。然后,她说,他跟着她回家,并坚持留宿。她说他睡在她客厅的地板上,直到早上他离开,她才感到安全。

Yudkowsky的书。来源:Eliezer Yudkowsky社区的指导原则可能被用来为这种行为辩护。其中许多人认为,理性导致对世界的优越结论,并使NPC的道德准则变得过时。前往旧金山湾区追求人工智能职业的女性Sonia Joseph在22岁时被鼓励与理性主义领域的一位40多岁的初创企业创始人共进晚餐,因为他与Peter Thiel有密切联系。在晚餐上,这位男士吹嘘说Yudkowsky以他为原型塑造了一个核心《HPMOR》教授。Joseph说,他还辩称,一个12岁的女孩与成年男性发生性关系是正常的,这种关系是向年轻一代传授知识的一种高尚方式。然后,她说,他跟着她回家,并坚持留宿。她说他睡在她客厅的地板上,直到早上他离开,她才感到安全。

在极端情况下,五名女性,其中一些要求匿名,因为害怕报复,称社区的男性对她们进行了性侵犯或不当行为。她们表示,在此后,她们经常不得不应对职业后果以及情感和社交方面的影响。社交圈与旧金山湾区的人工智能行业有很大的重叠,包括创始人、高管、投资者和研究人员。那些向警方或社区调解人员报告性虐待的女性说,她们被贴上麻烦制造者的标签,并遭到排斥,而男性却受到保护。

2018年,两人指控布伦特·迪尔(Brent Dill),一位为CFAR做志愿者和工作的理性主义者,虐待了他们,当时他们与他处于关系中。他们当时都是19岁,而他的年龄大约是他们的两倍。两位伴侣都表示,他利用药物和情感操纵来迫使她们参与远超出她们舒适程度的极端BDSM情景。作为对指控的回应,CFAR委员会传阅了一份对迪尔早期指控进行的调查摘要,该调查在很大程度上为他开脱。委员会写道:“他与CFAR的目标和战略一致,应被视为盟友”,称他为“一个重要的社区枢纽和推动者”,“体现了一种罕见的主动性和英雄责任感”。(在一片哗然之后,CFAR为其“非常不足”的回应道歉,解散了委员会,并禁止迪尔参加其活动。迪尔没有回应评论请求。)

Rochelle Shen,一位曾经经营过一个理性主义相关的团体住宅的创业者,听到社区中一位调解性侵指控的女性用了同样的辩解。调解员一再告诉Shen要考虑那名男子可能面临的后果。“你不想毁了他的事业,”Shen回忆道她说。“你要考虑对社区的影响。”

社区中一位不愿透露姓名以免受报复的女性表示,她曾遭到一位知名人工智能研究员的性虐待。在她面对他之后,她说,她收到的工作邀约被取消,会议演讲机会被撤销,还被取消了人工智能活动的邀请。她说,社区中的其他人告诉她,有关不当行为的指控损害了人工智能安全的进展,还有人建议她自杀是一种主动选择。

对于社区内声称受到虐待的一些女性来说,最具毁灭性的部分是幻灭。28岁的Angela Pang通过Quora上的帖子了解了理性主义者,她记得当她发现一个与她想法相同的社区时所感到的喜悦。她曾试验素食来减少动物的痛苦,很快就与有效利他主义的优化思想产生了联系。她说她曾遭到社区中的某人的侵犯,起初对自己的错误承认,但后来否认了。这种改口让她感到双重受害。“每个人都相信我,但他们的相信并不足够,”她说。“你需要那些非常关心虐待问题的人。”Pang在一个暴力家庭长大;她说她曾目睹家人在杂货店发生家庭暴力事件。旁观者盯着看,但继续购物。她说,这让她感到很相似。

社区中女性所声称的虐待行为并不会减弱AI安全的重要性。我们已经知道,当今的单一任务AI可能会扭曲结果,从种族主义的假释算法到性别歧视的薪酬差异。超级智能AI也必然会反映其创造者的偏见,无论是好是坏。但是,AI稍微更安全的可能性也不会使女性的安全变得不重要。

二十年前,尤德科夫斯基对AI安全的担忧是边缘化的。如今,它们背后有数十亿美元的支持,而且还在不断增加——谷歌投资了4亿美元在Anthropic公司,但以安全为重点的努力仍然只占行业投入于不断发展的AI军备竞赛的一小部分。OpenAI的ChatGPT可以通过法学考试;它的DALL-E可以为您绘制粉色的海豚跃过云端。微软正在试点在必应中使用AI搜索。尽管共识观点是真正有感知能力的AI还有一段距离,但研究和进步的速度正在迅速加快。

困扰该运动的问题变得更加相关,它的罪行也变得更加重要。尤德科夫斯基现在认为OpenAI的商业努力是“几乎是最糟糕的”道路,这将加速我们的毁灭。在上个月的播客中,他说他几乎失去了人类能够被拯救的所有希望。“问题在于召唤恶魔很容易,而召唤天使要困难得多,”他说。

2003年左右,当*《黑客帝国》*续集在影院上映,人工智能末日场景大多被 rel=“noopener”>夜间宿舍谈话,波斯特罗姆提出了一个关于人工智能的思想实验,该人工智能的唯一目标是制造尽可能多的回形针。该人工智能很快意识到,为了最大化其目标,不应该有人类存在:如果人类决定关闭人工智能,那将阻止回形针的制造,而人类体内含有可以制成回形针的原子。他得出结论,该人工智能将被强烈激励寻找方法来对我们和地球上的一切进行采矿以实现其目标。这种被称为回形针最大化器的概念,是关于痴迷于特定目标的危险的有力表述。

每个人工智能安全研究人员都知道回形针最大化器。很少有人似乎意识到这种亚文化正在模仿那种狭隘的视野。随着人工智能变得更加强大,那些痴迷于自我指定任务的人将感到越来越高的风险。已经发生的附带损害将不重要。他们只会考虑自己的一种回形针:拯救世界。