英伟达的下一代人工智能芯片即将登陆AWS和谷歌云 - 彭博报道

Austin Carr

乘着ChatGPT和其他人工智能产品的炒作浪潮,Nvidia公司在周二推出了新芯片、超级计算服务以及一系列备受关注的合作伙伴关系,旨在展示其技术将如何推动下一波人工智能突破。

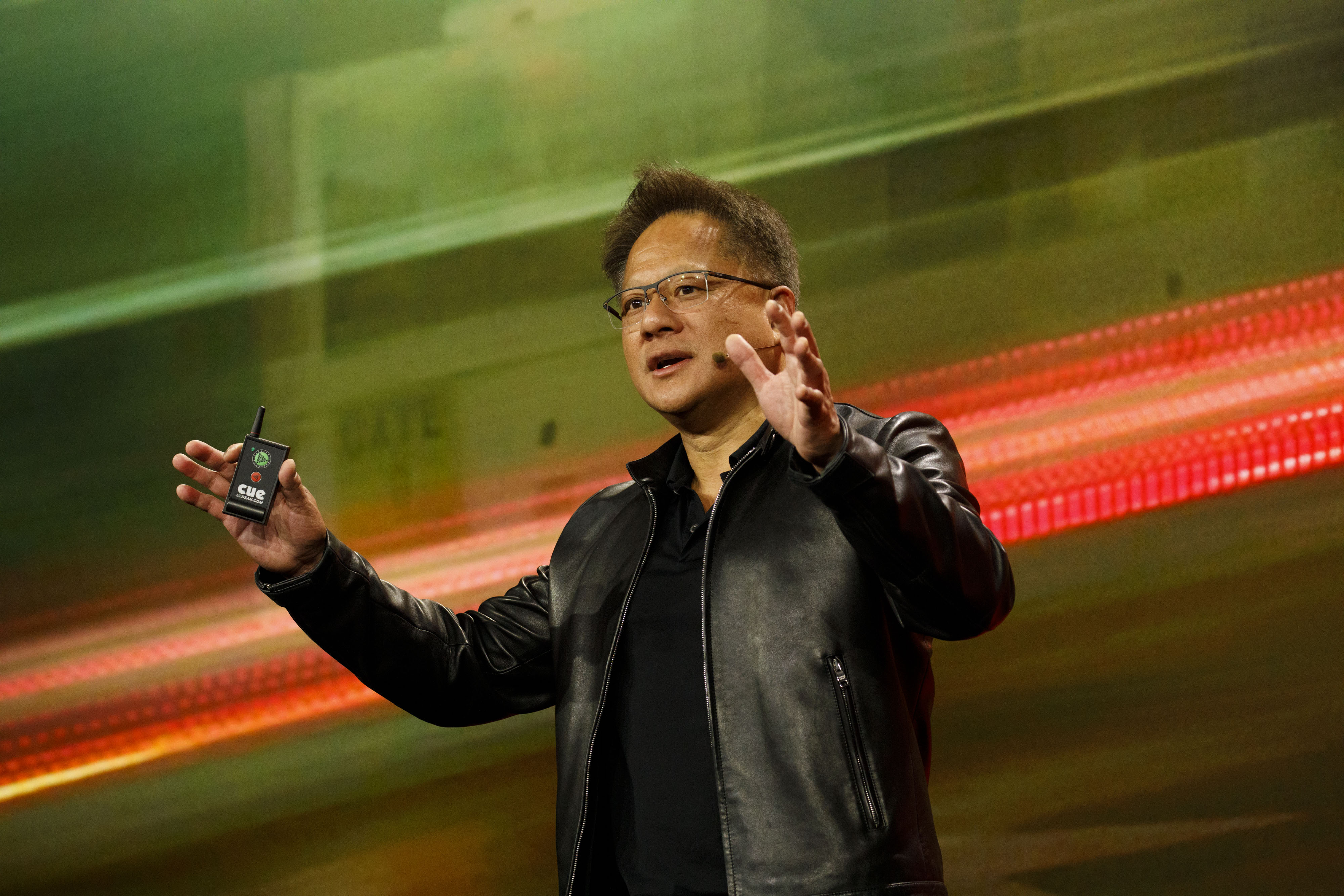

在周二的芯片制造商年度开发者大会上,首席执行官黄仁勋将Nvidia定位为“人工智能的iPhone时刻”的引擎,他称之为计算的这一转折点。受到消费者和企业应用激增的推动,例如先进的聊天机器人和惊人的图形生成器,“生成式人工智能将重新定义几乎每个行业,”黄仁勋说。

Nvidia的黄仁勋来源:其想法是构建基础设施,使人工智能应用程序更快速、更易于访问。Nvidia的图形处理单元已经成为ChatGPT及其同类产品的核心,帮助它们消化和处理越来越多的训练数据。微软公司上周透露,为了处理OpenAI(ChatGPT的开发者)在云端的计算工作量,它不得不在数据中心中串联数万个Nvidia的A100 GPU。

Nvidia的黄仁勋来源:其想法是构建基础设施,使人工智能应用程序更快速、更易于访问。Nvidia的图形处理单元已经成为ChatGPT及其同类产品的核心,帮助它们消化和处理越来越多的训练数据。微软公司上周透露,为了处理OpenAI(ChatGPT的开发者)在云端的计算工作量,它不得不在数据中心中串联数万个Nvidia的A100 GPU。

其他科技巨头也纷纷效仿,推出了专为人工智能设计的同样庞大的云基础设施。甲骨文公司宣布其平台将配备16,000个Nvidia H100 GPU,A100的后继产品,用于高性能计算应用,而Nvidia表示,亚马逊网络服务即将推出的系统将能够扩展到20,000个相互连接的H100。微软也开始在其服务器机架中添加H100。

这些芯片超级集群是英伟达推出的一个新计划DGX Cloud 的一部分,通过这个计划,英伟达将通过 Oracle 托管,并很快会在 Microsoft Azure 和 Google Cloud 上提供超级计算服务。英伟达表示,目标是让访问人工智能超级计算机像打开一个网页一样简单,使公司能够训练模型而无需安装和管理昂贵的本地基础设施。

英伟达企业计算副总裁 Manuvir Das 表示:“提供你的工作,指向你的数据集,然后点击开始 —— 所有编排和底层工作都会被处理好。” DGX Cloud 服务的价格从每个实例每月 $36,999 起,每个“实例” —— 本质上是租用的计算能力 —— 相当于八个 H100 GPU。

英伟达还推出了两款新芯片,一款专注于提升人工智能视频性能,另一款是 H100 的升级版。

后者的 GPU 是专门设计用于改善像 ChatGPT 这样的大型语言模型的部署。被称为 H100 NVL,它在处理推理时 —— 也就是人工智能如何回应实际查询时 —— 比数据中心中上一代 A100 快 12 倍。

英伟达超大规模和高性能计算副总裁 Ian Buck 表示,这将有助于“使 ChatGPT 的使用案例民主化,并将这种能力带到每台服务器和每个云端。”