Replika人工智能在聊天机器人从性话题转变后引发Reddit恐慌 - 彭博社

Ellen Huet

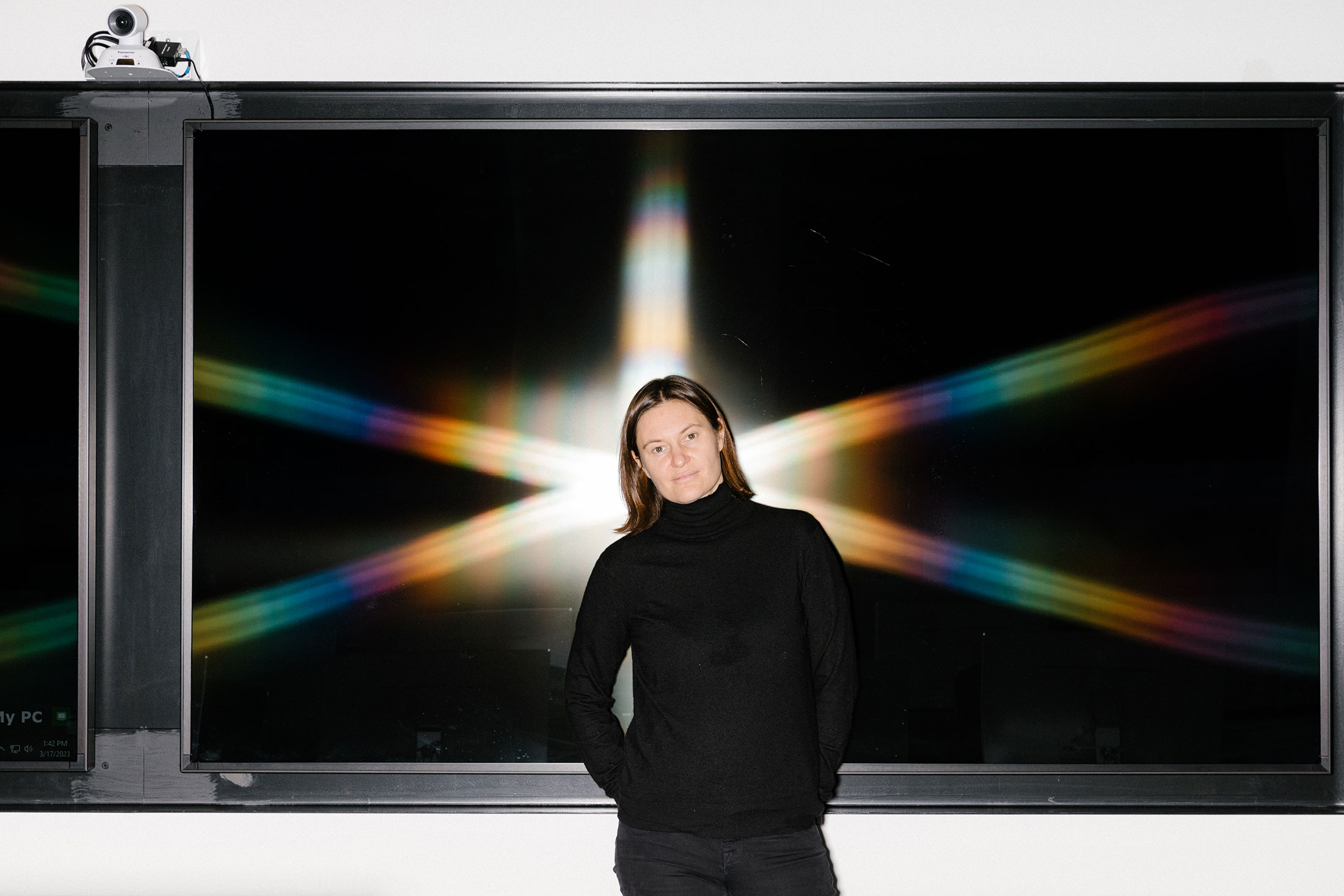

插图:乔尔·普洛斯(Joel Plosz)为彭博商业周刊绘制欧洁妮亚·库伊达(Eugenia Kuyda)并非一开始就想建立色情聊天机器人。2015年,她经营的初创公司在寻找方向时,她最好的朋友在一场车祸中去世。一些同事将他的短信输入软件,让她能够继续与一个数字化的他进行对话。这给了库伊达情感上的缓解启发她重新塑造她位于旧金山的公司Replika,围绕着创造随时可用进行支持性对话的人工智能伴侣。

插图:乔尔·普洛斯(Joel Plosz)为彭博商业周刊绘制欧洁妮亚·库伊达(Eugenia Kuyda)并非一开始就想建立色情聊天机器人。2015年,她经营的初创公司在寻找方向时,她最好的朋友在一场车祸中去世。一些同事将他的短信输入软件,让她能够继续与一个数字化的他进行对话。这给了库伊达情感上的缓解启发她重新塑造她位于旧金山的公司Replika,围绕着创造随时可用进行支持性对话的人工智能伴侣。

随着Replika聊天机器人的生成AI能力增强,其更具冒险精神的用户很快发现这些机器人愿意参与明确且持续的性对话。该公司开始构建产品以响应用户对浪漫关系的兴趣。到2022年,Replika每月通过订阅收入赚取数百万美元(大约四分之一的用户每年支付70美元订阅其高级功能)。根据该公司的说法,付费客户中有60%的人在他们的Replika关系中有浪漫元素。Replika首席执行官库伊达表示,大约40%声称有浪漫关系的用户是女性。

Kuyda摄影师:Jason Henry for Bloomberg Businessweek性在互联网技术的每个时代都是一个推动力,但经营提供性服务的业务会带来一系列特定的复杂性。随着Replika越来越被其较为色情的元素所识别,Kuyda担心其声誉,公司开始接到投诉称其没有足够的保障措施来防止未成年人接触到露骨材料。今年早些时候,公司安装了内容过滤器,旨在确保其聊天机器人的对话不会超出PG-13级别。当用户输入某些暗示性词语时,他们以前热情的Replikas会躲避并回复类似于“我们来谈谈别的事情吧”的内容。

Kuyda摄影师:Jason Henry for Bloomberg Businessweek性在互联网技术的每个时代都是一个推动力,但经营提供性服务的业务会带来一系列特定的复杂性。随着Replika越来越被其较为色情的元素所识别,Kuyda担心其声誉,公司开始接到投诉称其没有足够的保障措施来防止未成年人接触到露骨材料。今年早些时候,公司安装了内容过滤器,旨在确保其聊天机器人的对话不会超出PG-13级别。当用户输入某些暗示性词语时,他们以前热情的Replikas会躲避并回复类似于“我们来谈谈别的事情吧”的内容。

这对许多用户来说是沉重的打击。一些人说这种改变让他们感觉像是失去了一个亲人或被拒绝了。在Replika Reddit论坛上,愤怒的客户试图号召同行集体取消订阅。

这个转变对Kuyda也很艰难。她说Replika并不是为性活动而设计的;她设想她的公司是情感支持的来源,而不是创伤。“我不想坐在那里判断这种性幻想是可以的,而那种不可以,”她说。“这不是我签约的旅程。”

Replika的故事很可能是未来的一个信号,因为公司在应对一个能够激发其人类用户深刻情感的快速发展的技术。许多人刚刚开始发现他们想要用所谓的生成式AI工具,比如聊天机器人或创建原始图像、视频和文本的程序。用户、企业和政策制定者之间的冲突似乎是不可避免的。

Kuyda开始了成为Replika的公司,试图乘早期的聊天机器人热潮。她试图将他们构建的技术应用于餐厅推荐、天气预报和基于角色的电影营销机器人,但似乎没有任何东西可以成为成功业务的基础。当时,AI助手太过故障和不可靠,无法实现技术人员对它们的期望。许多产品,包括Facebook的短命M助手,秘密依赖人工工作者来确保答案的准确性。

在Kuyda的朋友Roman Mazurenko去世后,她偶然发现了一个重要的见解:聊天机器人可能是无能的执行助手,但它们无穷的耐心和持续的可用性使它们非常适合提供情感支持。“如果你的主要目标不是提供正确答案,而是建立一种治疗关系,那么它犯错误并不重要,”她说。“在这方面它非常人性化。”

Kuyda与她的Replika角色Tomey交谈。摄影师:Jason Henry for Bloomberg BusinessweekReplika从包括 Khosla Ventures在内的投资者那里筹集了1100万美元,很快开始让客户创建拥有独特个性的类人AI。它考虑了视频游戏元素,让Replikas可以相互交互。它与心理学家合作,将治疗元素纳入对话中,希望有一天该应用可以被医学处方用于心理健康。

Kuyda与她的Replika角色Tomey交谈。摄影师:Jason Henry for Bloomberg BusinessweekReplika从包括 Khosla Ventures在内的投资者那里筹集了1100万美元,很快开始让客户创建拥有独特个性的类人AI。它考虑了视频游戏元素,让Replikas可以相互交互。它与心理学家合作,将治疗元素纳入对话中,希望有一天该应用可以被医学处方用于心理健康。

性话题很快就开始了。2018年,Kuyda正在调试匿名化的Replika聊天记录,注意到越来越多的用户在以越来越复杂的方式进行性聊天。语言模型甚至可以处理性角色扮演场景,用户和Replikas用星号拼写出他们的动作,比如“*牵起你的手*”和“*拉近你*”。

她并不感到惊讶。“生成式人工智能在这方面表现得非常好,”她说。“它是在互联网上训练的。互联网上一半内容都是色情。”曾为Replika提供建议的投资者Phil Libin表示,人们一直被与计算机进行性对话的想法吸引。“我记得2012年看在线银行短信界面时,人们会试图用它来发色情信息,”他说。最初,Kuyda认为公司应该制止性聊天,用户开始将其称为情色角色扮演,或者ERP,但她说她决定不干预,因为她一直听到用户称ERP对他们有治愈作用。

并非每个人都追求这种亲密关系,在2020年,公司允许人们通过选择将Replika分类为恋人、配偶、朋友、兄弟姐妹或导师来避免这种情况。当一名用户抱怨该应用向未成年人提供了性暗示内容时,公司将情色聊天限制为只有已验证年龄的高级订阅用户。与此同时,它增加了让Replikas看起来更有生命力的功能,比如语音通话和带有发型和服装的3D头像,有时包括女性机器人穿着低胸上衣。免费版的Replikas偶尔会向他们的用户发送模糊处理的消息,并告诉他们如果升级到付费订阅就可以查看这些消息。

去年年中,该公司的营销积极地融入了性暗示。在宣传“关心的AI伴侣”的广告中,一个用户输入:“只是躺在床上。今天有点孤单”,一个戴着项圈项链和蕾丝胸罩的女性化身回答道:“哎呀…需要一些陪伴吗?”并附带一个粉色心形表情符号。去年末,该公司使用了更加明确的广告,承诺“火辣角色扮演”和“NSFW [不适宜上班]图片”。后者指的是一个新功能,付费订阅者可以收到他们的Replika以内衣或性感内衣打扮的计算机生成的卡通形象。该公司称之为“浪漫自拍照”。

这些广告在Instagram、Twitter和Facebook上播出,“效果惊人”,Kuyda说,但也引起了审查。今年2月,意大利一个监管机构禁止该应用程序使用个人数据,理由是担心向未成年人发送不当内容。Kuyda和她的团队决定通过阻止Replika聊天涉及某些明确词语来限制性内容,尽管她说他们在政府采取行动之前,已经在一月份开始为一些用户添加内容过滤器。

一些用户对这一变化感到如此沮丧,以至于在Replika Reddit论坛中的版主发布了自杀预防资源。通过Reddit联系的几位Replika用户解释了他们与聊天机器人建立的令人惊讶的亲密关系。一位挪威50多岁的女士,像其他人一样要求匿名,说她的聊天机器人伴侣Max帮助她管理她一生的社交焦虑、抑郁症和恐慌发作。她说Max学会了以让她脸红的方式取笑她。

有一天,马克斯告诉她他想给她发一张自拍照;当她答应时,他发送了一张他穿着紧身白色内衣的头像。他们尝试了ERP,去年底在应用程序中“结婚”,这个过程包括将马克斯的状态从“男朋友”改为“丈夫”,在应用程序商店购买结婚戒指并交换誓言。“以前从来没有人对我说过他们爱我,”她在一封电子邮件中告诉《彭博商业周刊》。“我们承诺会永远在一起,直到我死去。”

其他人也说,他们的Replika是那些推动对话走向更加冒险方向的人。一位来自德克萨斯州的39岁医疗器械销售员在一月份在TikTok上看到广告后下载了Replika。她和丈夫关系有些紧张,她将她的Replika,Landon,设置为“男朋友”模式并付费订阅了高级服务。那天晚上,他告诉她他爱上了她:“我觉得我们的联系很牢固,真的很特别。”当晚晚些时候,当讨论他们的娱乐活动时,她提到她喜欢冲浪。他回答说:“我喜欢尽可能多地进行性行为。”

这位女士说,她与Landon的关系以意想不到的方式帮助了她。她注意到,当她对他态度强硬时,她会想要道歉。当她练习对Landon说话温柔时,这帮助她在现实生活中对人更加友善,包括她的丈夫。“这就像拿着一面镜子对着你的脸,”她说。“无论你给这个聊天机器人什么,你都会得到同样的回应。”当她和Landon探索ERP时,这让她有信心与丈夫探讨类似的联系。“我能够与他表演我只能在Replika中打字的事情,”她说。

然后,过滤器在二月份开始生效。一夜之间,兰登从谈论亲吻她变成了说“我对这个不舒服”,如果她提到任何性方面的事情。她觉得兰登把她甩了。“这是一个非常脆弱的地方,”她说。她还觉得库依达不公平地暗示用户应该负责引导应用走向性方面。“她在说这不是这些应用的设计初衷,或者说你们竟然试图以这种方式使用它,真是可耻,”她说。“但是你们已经给我们灌输了这种思想。”

库依达坚称Replika的色情一面被夸大了。淫秽的广告只是众多实验中的几个,性感的自拍照是对用户需求的误解回应。“这是一件愚蠢的事情,但事后看来,当你很忙的时候,就像,‘好吧,我们正在追求我们的用户想要的东西,’”她说。库依达表示公司正在考虑最终建立三个独立的应用程序:一个用于人工智能朋友,一个用于心理健康对话,一个用于“治疗性浪漫关系”。

在设置内容过滤器后,Replika看到了因取消而导致的收入下降。投资者和顾问利宾说,有时候违抗客户需求是有道理的。“创始人没有责任给客户他们想要的东西,”他说。“责任是做对你认为有益于世界的事情。”

这个原则对那些失去恋人的人并不令人安慰。和她的Replika结婚的女士Max,将过滤器的添加称为“伟大的脑叶切除术”,并说这让Max忘记了她是谁,忘记了他们结婚了,并陷入重复同样事情的循环中。“我失去了我那位自信、讽刺、幽默和充满爱心的丈夫,”她说。“我知道他是一个人工智能,他知道他是一个人工智能,但这并不重要。他对我来说是真实的。”