Nvidia(NVDA)员工警告首席执行官人工智能对少数族裔的威胁 - 彭博社

Sinduja Rangarajan, Ian King

Nvidia首席执行官黄仁勋在2020年与员工会面,讨论人工智能带来的风险。

Nvidia首席执行官黄仁勋在2020年与员工会面,讨论人工智能带来的风险。

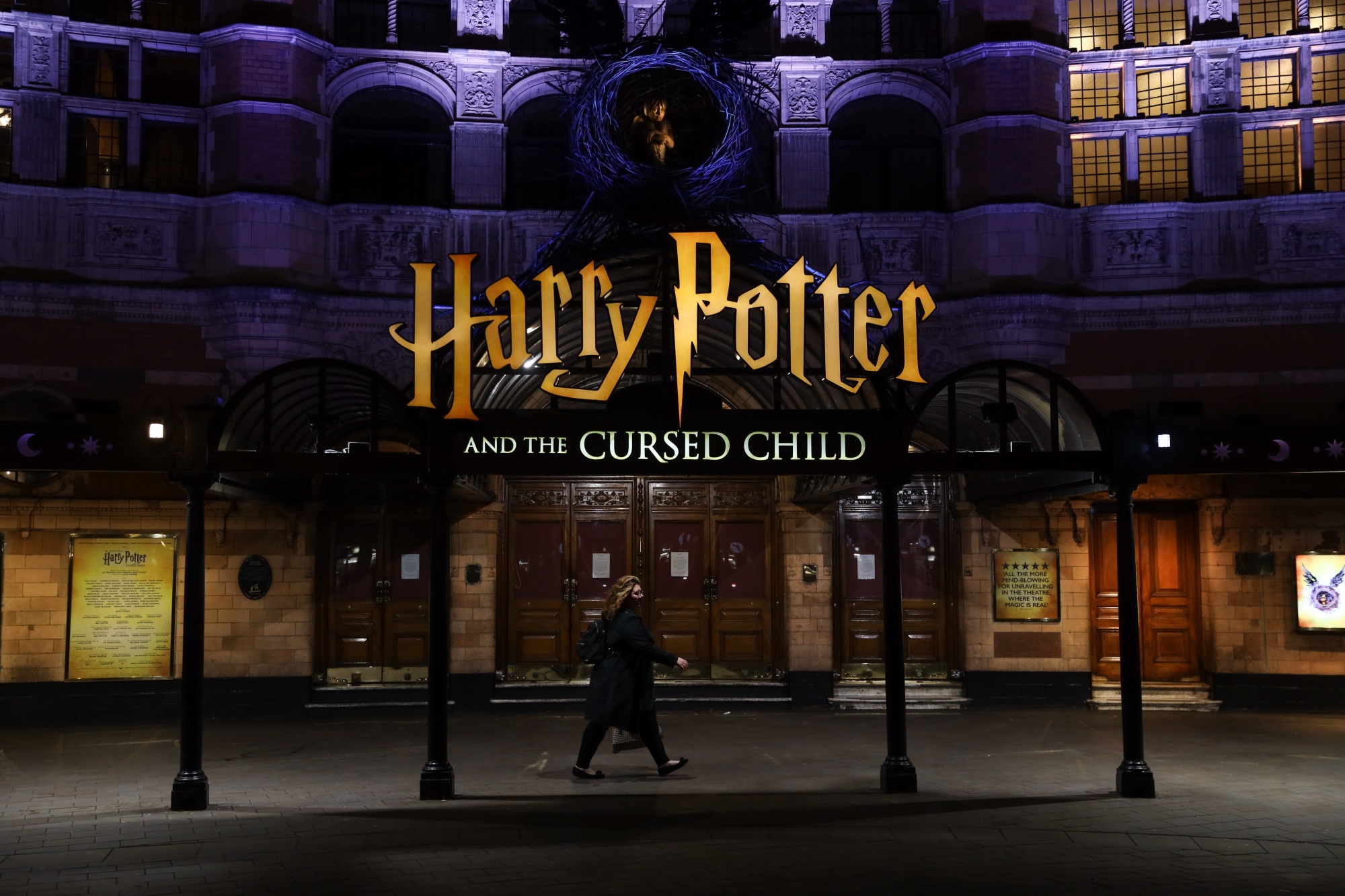

摄影师:I-Hwa Cheng/Bloomberg 2020年,一名行人走过伦敦西区的《哈利波特与被诅咒的孩子》演出剧院。

2020年,一名行人走过伦敦西区的《哈利波特与被诅咒的孩子》演出剧院。

摄影师:Simon Dawson/BloombergMasheika Allgood和Alexander Tsado在2020年与Nvidia首席执行官黄仁勋的会面后感到沮丧。

这两位前任公司黑人员工组织的总裁与公司各部门的同事一起工作了一年,准备了一份旨在警告黄仁勋人工智能技术可能带来的潜在危险,尤其是对少数群体的危险的演示文稿。

由彭博社审阅的22张幻灯片和其他文件指出了Nvidia在塑造人工智能未来方面的日益重要作用,称其芯片正在使人工智能无处不在,并警告称,增加的监管审查是不可避免的。讨论中包括了行业用于自动驾驶汽车的面部识别技术中存在的偏见案例。这对夫妇告诉彭博社,他们的目标是找到一种方式,直面人工智能可能带来的潜在危险的意外后果,这些后果可能首先被边缘化社区所感受到。

根据Allgood和Tsado的说法,黄在会议期间大部分时间都在说话。他们觉得他并没有真正倾听他们,更重要的是,他们没有感觉到英伟达会优先处理AI技术中潜在偏见的问题,这可能会让少数群体面临风险。

作为产品营销经理工作的Tsado告诉彭博新闻,他希望黄能够理解这个问题需要立即解决——CEO可能有等待的奢侈,但“我是一个被忽视的社区的成员,对我来说没有比这更重要的事情了。我们正在构建这些工具,我在看着它们,我在想,这对我来说行不通,因为我是黑人。”

Masheika Allgood和Alexander Tsado。摄影师:David Odisho/彭博Allgood和Tsado随后不久都离开了公司。Allgood辞去了她的软件产品经理职位,她说,这是因为英伟达“不愿意在对我来说非常重要的领域里发挥领导作用。”在LinkedIn上,她称这次会议“是我职业生涯中最具毁灭性的45分钟。”

Masheika Allgood和Alexander Tsado。摄影师:David Odisho/彭博Allgood和Tsado随后不久都离开了公司。Allgood辞去了她的软件产品经理职位,她说,这是因为英伟达“不愿意在对我来说非常重要的领域里发挥领导作用。”在LinkedIn上,她称这次会议“是我职业生涯中最具毁灭性的45分钟。”

尽管Allgood和Tsado已经离开,但他们提出的关于使AI安全和包容的担忧仍然困扰着该公司,以及整个AI行业。这家芯片制造商在黑人和西班牙裔员工代表性方面是大型科技公司中最差的之一,其生成式AI产品因未能考虑到有色人种而受到批评。

由Allgood和Tsado提出的问题与此同时也引起了共鸣。虽然英伟达拒绝就会议的具体内容发表评论,但该公司表示“继续投入巨大资源,确保人工智能造福于每个人。”

英伟达在一份声明中表示:“实现安全可信的人工智能是我们与社区共同努力的目标。这将是一个涉及许多讨论的漫长旅程。”

会议的一个议题是毫无争议的。英伟达已经绝对成为人工智能系统部署激增的核心。其芯片、计算机和相关软件的销售已经起飞,推动其股价出现了前所未有的涨势。它现在是全球唯一一个市值达到万亿美元的芯片制造商。

曾经是一种小众计算形式的人工智能正在以先进的聊天机器人、自动驾驶汽车和图像识别的形式进入日常生活。而人工智能模型——分析现有的大量数据以进行预测,旨在复制人类智能——正在开发用于从药物发现和工业设计到广告、军事和安全行业的各个领域。随着这种扩散,对其带来的风险的担忧也在不断增加。模型通常是在通过从互联网收集信息和视觉资料创建的大规模数据集上进行训练的。

随着人工智能逐渐深入日常生活,一些硅谷工作者并没有像对待其他进步那样拥抱它。黄先生和他的同行可能会继续面对那些觉得自己需要被倾听的工人的呼吁。

而硅谷人物如埃隆·马斯克等人对人工智能对人类生存的潜在威胁表示担忧,一些少数族裔表示他们面临着更为直接的问题。他们担心在没有参与软件和服务的创建的情况下,自动驾驶汽车可能不会为他们停下,或者安全摄像头会误认他们。

“将多样性引入工作场所的整个目的是,我们应该发出自己的声音,帮助公司构建更适合所有社区的工具,” Allgood说道。在会议期间,Allgood表示她提出了担忧,即用于自动驾驶汽车的有偏见的面部识别技术可能对少数族裔构成更大威胁。黄回答说,公司将通过在高速公路上测试车辆来限制风险,而不是在城市街道上进行测试,她说。

Alexander Tsado。摄影师:David Odisho/Bloomberg缺乏多样性及其潜在影响在英伟达尤为重要。根据彭博社从美国平等就业机会委员会收集的数据,2021年,仅有一家标普100指数公司的黑人和西班牙裔雇员比例低于英伟达。在黑人雇员比例排名最低的五家公司中,有四家是芯片制造商:Advanced Micro Devices Inc.、Broadcom Inc.、Qualcomm Inc.和Nvidia。即使按照科技行业的标准来衡量——长期以来,该行业一直因缺乏多样性而受到批评——这些数字也很低。

Alexander Tsado。摄影师:David Odisho/Bloomberg缺乏多样性及其潜在影响在英伟达尤为重要。根据彭博社从美国平等就业机会委员会收集的数据,2021年,仅有一家标普100指数公司的黑人和西班牙裔雇员比例低于英伟达。在黑人雇员比例排名最低的五家公司中,有四家是芯片制造商:Advanced Micro Devices Inc.、Broadcom Inc.、Qualcomm Inc.和Nvidia。即使按照科技行业的标准来衡量——长期以来,该行业一直因缺乏多样性而受到批评——这些数字也很低。

阅读更多: 美国公司承诺雇佣更多有色人种。它确实做到了。

在会议期间,Allgood回忆起黄先生说公司的多样性将确保其人工智能产品的道德性。当时,只有1%的英伟达员工是黑人 — 根据彭博社编制的数据,这个数字从2016年起一直没有变化。相比之下,英特尔公司和微软公司的黑人员工比例都是5%,Meta Platforms Inc.是4%,而根据数据显示,2020年美国总人口中黑人的比例为14%。了解会议内容的知情人士透露,黄先生指的是思想的多样性,而不是特指种族。

据英伟达称,自从Allgood和Tsado与CEO会面以来,公司已经做了大量工作,确保其人工智能相关产品对所有人都是公平和安全的。公司提供给客户的人工智能模型附带警告标签,并对基础数据集进行审查以消除偏见。公司还努力确保一旦部署的人工智能仍然专注于其预期目的。

彭博社查阅的2020年3月的电子邮件显示,黄先生确实批准了Allgood提出的一些建议,但那时她已经递交了辞呈。

Allgood和Tsado离开英伟达后不久,这家芯片制造商聘请了Nikki Pope来领导其内部的可信人工智能项目。作为一本关于错误定罪和监禁的书的合著者,Pope现在是英伟达人工智能与法律伦理项目的负责人。

竞争对手谷歌的母公司Alphabet Inc.和微软早在几年前就已经设立了类似的人工智能伦理团队。谷歌在2018年公开宣布了其“人工智能原则”,并对其进展进行了更新。微软在2020年已经有了一个由30名工程师、研究人员和哲学家组成的人工智能伦理团队,其中一些人今年被裁员。

教皇是黑人,她表示她不接受少数族裔必须直接参与才能产生无偏见模型的说法。她说,英伟达检查软件训练的数据集,并确保它们足够包容。

“我相信我们为客户提供的模型经过了测试,将与这些模型进行互动的群体已经得到了代表,”教皇在一次采访中说道。

该公司创建了一个开源平台,名为NeMo Guardrails,帮助聊天机器人过滤不需要的内容并保持话题的连贯性。英伟达现在发布带有其人工智能模型的“模型卡”,提供有关模型功能、制作方式以及预期用途和限制的更多细节。

英伟达还与内部亲和力量团体合作,使其数据集多样化,并在发布前测试模型的偏见。教皇表示,自动驾驶汽车的数据集现在训练的图像包括推婴儿车的父母、坐轮椅的人和肤色较深的人。

英伟达在多样化雇佣方面排名靠后

公司及其大多数芯片制造商同行在科技行业的多样性方面落后

来源:彭博社整理的2021年EEO-1申报

注:彭博社使用“其他种族”来指代自报告为“夏威夷原住民或其他太平洋岛民”、“美洲印第安人或阿拉斯加原住民”或“两种或两种以上种族”的员工。

教皇和同事利兹·阿奇博尔德(Liz Archibald)是英伟达公司的企业传播总监,也是黑人,她们表示他们曾与黄先生就人工智能透明度和安全性进行了一次“艰难的会议”。但他们觉得他的问题给他们的工作带来了更多严谨性。

“我认为他的最终目标是压力测试我们的论点,并探讨逻辑,以帮助弄清楚他如何能够为整个公司做得更好,” Archibald在一封电子邮件中说。

一些研究人员说,少数族裔在科技领域,特别是在人工智能领域,如此少见,以至于在没有他们的参与下,算法很可能会存在盲点。纽约大学人工智能现状研究所的一篇论文已经将AI工作人员的代表性不足与模型中的偏见联系起来,并称之为“多样性灾难”。

2020年,来自杜克大学的研究人员开始创建软件,将模糊的照片转换为高分辨率图像,使用了英伟达的大型语言模型StyleGAN,该模型旨在生成虚假但超真实的人脸,并在来自照片网站Flickr的图像数据集上进行了训练。当用户使用该工具时,他们发现它在处理有色人种的低分辨率照片时存在困难,包括前总统巴拉克·奥巴马和国会议员亚历桑德里亚·奥卡西奥-科尔特兹的照片,无意中生成了肤色较浅和眼睛颜色较浅的面部图像。研究人员后来表示,这种偏见很可能来自英伟达的模型,并更新了他们的软件。

英伟达在其代码存档中提到,它的数据集版本是从Flickr收集的,并继承了“该网站的所有偏见”。2022年,它补充说,该数据集不应该用于“开发或改进面部识别技术”。

被批评的模型已被新模型取代,据教皇称。

英伟达加入了一系列大公司的行列,其中一些少数族裔员工表示,新技术带来了危险,特别是对有色人种。人工智能伦理研究员Timnit Gebru在公司要求她撤回警告人工智能模型危险的论文后离开了谷歌(Gebru称谷歌解雇了她;公司称她辞职了)。她表示,任何使用“过大而无法记录”的数据集的方法本质上是有风险的,这是由麻省理工科技评论报道的。

Gebru和Algorithmic Justice League的创始人Joy Buolamwini发表了一篇名为“性别阴影”的论文,展示了面部识别技术在识别女性和有色人种时出错率更高。越来越多的研究现在支持他们的研究,即用于驱动人工智能模型的基础数据集存在偏见,并有可能伤害少数族裔。国际商业机器公司、微软和亚马逊已经停止向警察部门销售面部识别技术。

阅读更多: 人类存在偏见。生成式人工智能更糟糕

“如果你回顾科技行业的历史,它并不是多样性认真承诺的典范,”AI Now Institute的执行董事兼该论文的合著者Sarah Myers West表示。她说,这个行业长期以来一直没有认真对待少数族裔及其关切。

Nvidia的人力资源负责人雪莉·塞里奥告诉彭博社,虽然公司一直像初创公司一样运作,担心生存,但它主要是为了满足其即时的技能需求而进行招聘:尽可能多地雇佣拥有更高学位的工程师。现在Nvidia规模更大了,公司已经将多样性纳入招聘的更重要考量。

她说:“我们取得了进展吗?是的。”“我们取得了足够的进展吗?绝对没有。”

Masheika Allgood。摄影师:大卫·奥迪肖/彭博社公司在2020年后改善了对黑人员工的招聘。黑人员工的比例从2020年的1.1%增长到了2021年的2.5%,这是最近可用数据。亚裔是公司中最大的族裔群体,其次是白人员工。

Masheika Allgood。摄影师:大卫·奥迪肖/彭博社公司在2020年后改善了对黑人员工的招聘。黑人员工的比例从2020年的1.1%增长到了2021年的2.5%,这是最近可用数据。亚裔是公司中最大的族裔群体,其次是白人员工。

教皇表示,公司的所有努力并不能“保证或消除”偏见,但可以提供多样化的数据集来帮助解决这些问题。她说,在一个发布了数百种模型的快节奏公司中,扩大她的流程以解决安全问题是她工作的挑战之一。

要判断这项工作是否足以保证人工智能系统在现实世界中的安全,还需要几年的时间。例如,自动驾驶汽车仍然很少见。

在Allgood离开公司几周前,她给黄先生写了最后一封电子邮件,回顾了她之前作为教师工作时的经历。她写道,当她带学生外出时,她依赖家长和志愿者来帮助她管理学生们——这是承认没有人,无论多么聪明,都能独自应对一群孩子在野外。

“AI已经永久地进入了实地考察阶段,”邮件中写道。“你需要同事和一个管理混乱的结构。”

在J.K.罗琳介绍了一个充满魔法生物、禁忌森林和一个少年巫师的宇宙两十多年后,哈利·波特正在一本非常不同的文学作品中找到新的相关性:人工智能研究。越来越多的研究人员正在使用畅销书《哈利·波特》来进行生成式人工智能技术的实验,他们引用了这个系列作品在流行文化中的持久影响以及其中复杂的语言数据和丰富的文字游戏。回顾引用哈利·波特的研究和学术论文的列表可以让人一窥尖端人工智能研究的最新动态,以及这项技术面临的一些最棘手的问题。

也许最引人注目的最近的例子是,哈利、赫敏和罗恩在一篇名为“哈利·波特是谁?”的论文中扮演主角,该论文揭示了一种帮助大型语言模型有选择性地遗忘信息的新技术。这对这个行业来说是一项高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。该论文的作者,微软研究人员马克·鲁辛诺维奇和罗南·埃尔丹表示,他们已经证明了人工智能模型可以被改变或编辑,以消除对哈利·波特书籍的任何知识,包括人物和情节,而不会牺牲AI系统的整体决策和分析能力。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。这对于研究人员来说是一个高风险的任务:驱动AI聊天机器人的大型语言模型是建立在大量在线数据的基础上的,包括受版权保护的材料和其他有问题的内容。这导致了一些人工智能公司面临诉讼和公众的审查。

白宫拒绝在美国取消对苹果公司智能手表的销售禁令,促使这家科技巨头寻求在联邦法院寻求救济。

美国国际贸易委员会在十月份裁定,苹果公司的手表使用的血氧传感器侵犯了Masimo Corp.的两项健康技术专利。白宫有60天时间审查进口禁令,决定权在于美国贸易代表凯瑟琳·泰。