你的医疗设备变得更智能了美国食品药品监督管理局能确保它们安全吗?- 华尔街日报

Ryan Tracy

医疗设备中使用人工智能正在迅速增长,为潜在的挽救生命的进步铺平道路,也给负责确保新产品安全的监管机构带来了艰巨挑战。

如果科技公司得逞,焦虑的患者可能有一天选择与聊天机器人交谈,而不是与人类心理治疗师交谈。前往医院的患者将通过AI驱动的风险计算器进行评估,自动助手将帮助进行测试。这样的AI应用,在用于诊断或治疗时,将符合食品药品监督管理局的医疗设备标准,这意味着开发者可能需要该机构的许可才能将其推向市场。

随着人工智能革命加速,FDA是众多美国机构之一,正在努力找到正确的政策。从2020年到2022年底,FDA批准了300多个具有人工智能功能的设备,比整个上一个十年的数量还要多。曾任FDA食品药品主要副专员的艾米·艾伯内西说:“我们面临着一列高速行驶的列车,即将面临挑战。”她现在是Alphabet旗下Verily Life Sciences的首席医疗官,该公司生产具有人工智能功能的医疗设备。

几十年来,该机构一直将医疗设备视为静态化合物,就像对待药物一样。当FDA批准一种设备时,制造商可以销售该版本。在升级到新版本之前,他们需要监管机构的批准。但是,AI设备通常使用旨在快速更新甚至自主学习的算法。该机构正在努力应对这种快速发展的技术,同时确保设备的安全性。

“AI 动力产品的一个关键优势是它可以随着时间改进,” Inflammatix 的首席执行官 Tim Sweeney 说,该公司是一家开发血液测试以预测感染的存在、类型和严重程度的开发商。例如,如果公司发现特定的免疫反应模式强烈表明败血症的发作,它会希望重新训练其算法以考虑这一点。“如果你有很多额外的数据,你应该改进你的结果,” Sweeney 说。

然而,在 FDA 传统的监管方法下,像 Inflammatix 这样的公司可能需要在改变其算法之前获得额外的许可。

该机构开始引导开发者走一条替代路径,今年四月发布了关于如何提交更灵活的使用 AI 设备计划的正式指导。制造商可以提交一个“预定变更控制计划”,概述预期的改变。FDA 的工作人员,包括律师、医生和技术专家,会审查这些计划和预期变更的范围。一旦设备获得批准,公司可以在不需要 FDA 批准的情况下改变产品的编程,只要这些改变是计划的一部分。

目标是“确保市场在继续推动他们正在进行的创新边界的同时,仍然遵守我们批准产品时建立的监管框架,” FDA 数字健康卓越中心主任 Troy Tazbaz 说。

许多设备制造商对 FDA 的方向表示赞赏,尽管他们要求该机构就其允许的变更范围提供更多的明确性。“事先确定我们可能想要做的可能变更是具有挑战性的,” Lara Jehi 说,她作为克利夫兰诊所健康系统的首席研究信息官,帮助开发了基于 AI 的患者评估工具。“科学中唯一可预测的事情就是不可预测性。”

NeuroPace,一家制造治疗严重癫痫的脑植入物的公司,该公司的首席医疗官玛莎·莫雷尔表示,他们将考虑将“变更控制计划”作为其设备新版的人工智能版本的一部分。

莫雷尔表示,作为一个“A型医生”,即使她也感到不舒服将这种权力交给设备。但她也相信患者将受益,并且FDA和公司需要找出必要的标准,以确保设备是安全的。

她预测,在FDA关于人工智能设备的最新指导之后,“随之而来的将会有另一个,再接着又是另一个,因为我们在争分夺秒地跟上这个巨大的变革。”

批评者认为FDA的新方向可能会引入风险,指出曾经有医疗设备软件错误对患者造成严重危险。他们表示,人工智能系统会带来额外的挑战,因为负责这些系统的人并不总是完全了解它们的工作方式和潜在问题,比如种族偏见等问题可能很难衡量。“人工智能带来了非常不同的危害——难以理解和解释的算法危害,”佛罗里达州立大学的健康法学教授梅森·马克斯表示。他说,允许对复杂算法进行更改而无需经过监管审查,“FDA给制造商很大的自由度。”

一位FDA发言人表示,该机构对设备的评估涉及潜在偏见。

未来,这些担忧可能会通过FDA一些官员讨论的新政策得到解决:要求在AI设备上市后进行实时监测。这将与传统方法有所不同,传统方法是FDA批准的设备制造商只需报告可能影响患者的“不良事件”。新的监测要求旨在确保制造商密切关注其算法的性能。但要采纳这些要求可能需要FDA目前没有的法律权限。如果行业团体认为这些要求过于侵入,它们可能会游说反对该机构获得这种权限。

随着越来越多的开发者将生成式AI系统纳入其产品,这些争论将变得更加紧迫,这些系统可以生成类似人类的文本、照片、视频和其他媒体。

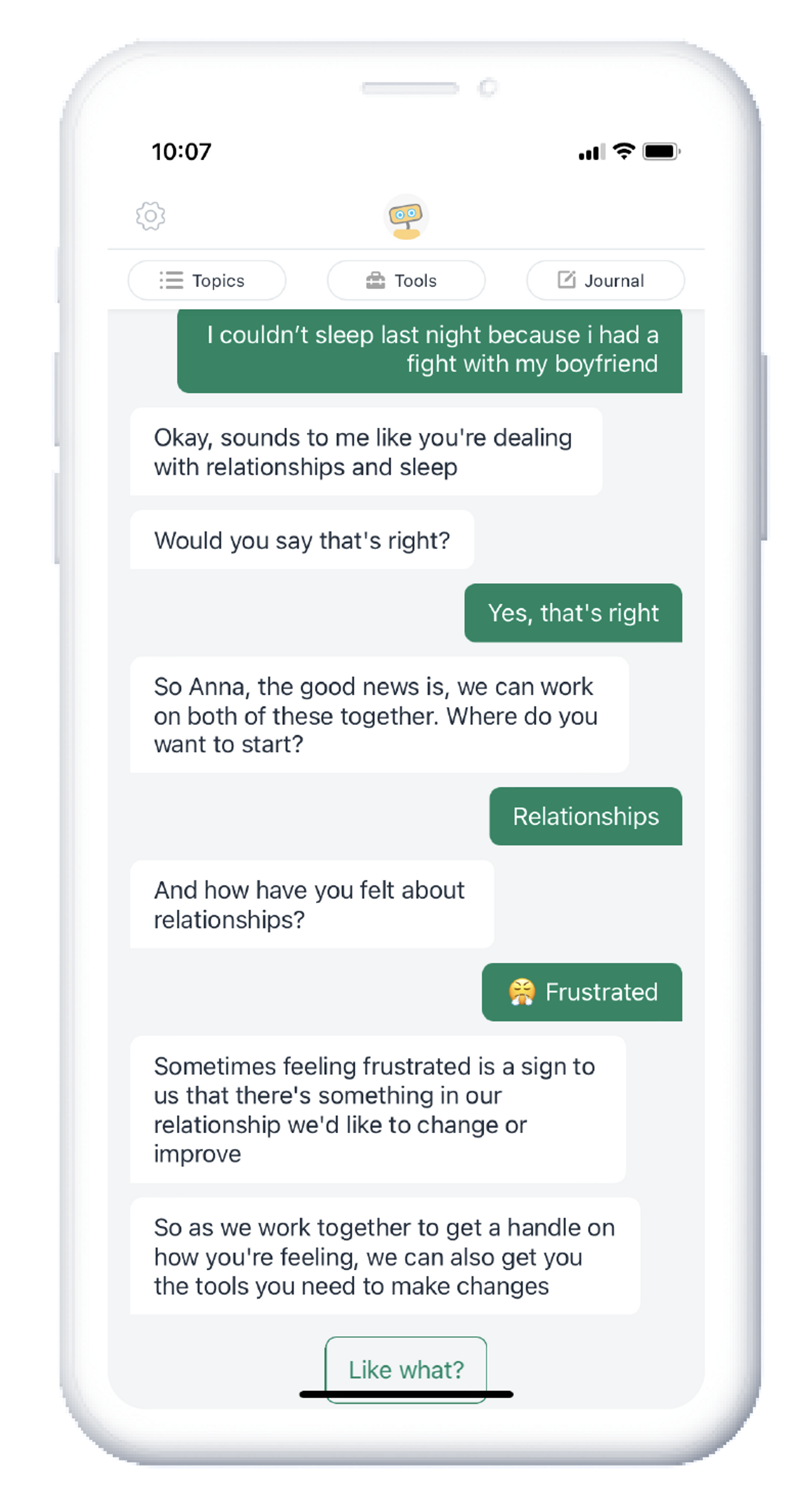

Woebot Health推出了一款希望精神科医生、医生或保险公司会推荐的机器人,以帮助患者解决心理健康问题。该机器人提供鼓励并全天候回应。作为一项安全措施,Woebot表示,其回应仅限于人类预先批准的选择。该公司正在测试使用生成式AI模型来帮助理解用户的言论,但对于允许开放对话持谨慎态度。

Woebot表示希望寻求FDA的批准。但它也希望能够在不需要处方的情况下推广其产品,以触及更广泛的用户群。通常获得FDA批准的心理健康“数字治疗”产品并不直接面向消费者销售。“我们如何确保这些工具经过临床验证,但不一定需要处方?”Woebot的监管科学和战略副总裁Robbert Zusterzeel说。“在某个时候,FDA需要考虑这个中间选项。”

这指向了FDA政策的另一个潜在影响:该机构的监管边界最终塑造了产品开发。

“这创造了一套有趣的激励机制。”哈佛商学院教授Ariel Dora Stern说,她研究了FDA监管。“我曾经与一些初创公司交谈,它们基本上只解决了比它们的算法可以解决的更小的问题,仅仅是因为他们不想接触监管。”

写信给Ryan Tracy,邮箱地址为[email protected]

刊登于2023年10月12日的印刷版上,标题为“医疗设备变得更智能。FDA能跟得上吗?”。