Deepfakes、能源、中国、战争和选举:AI政治已经来临 - 彭博社

Niall Ferguson

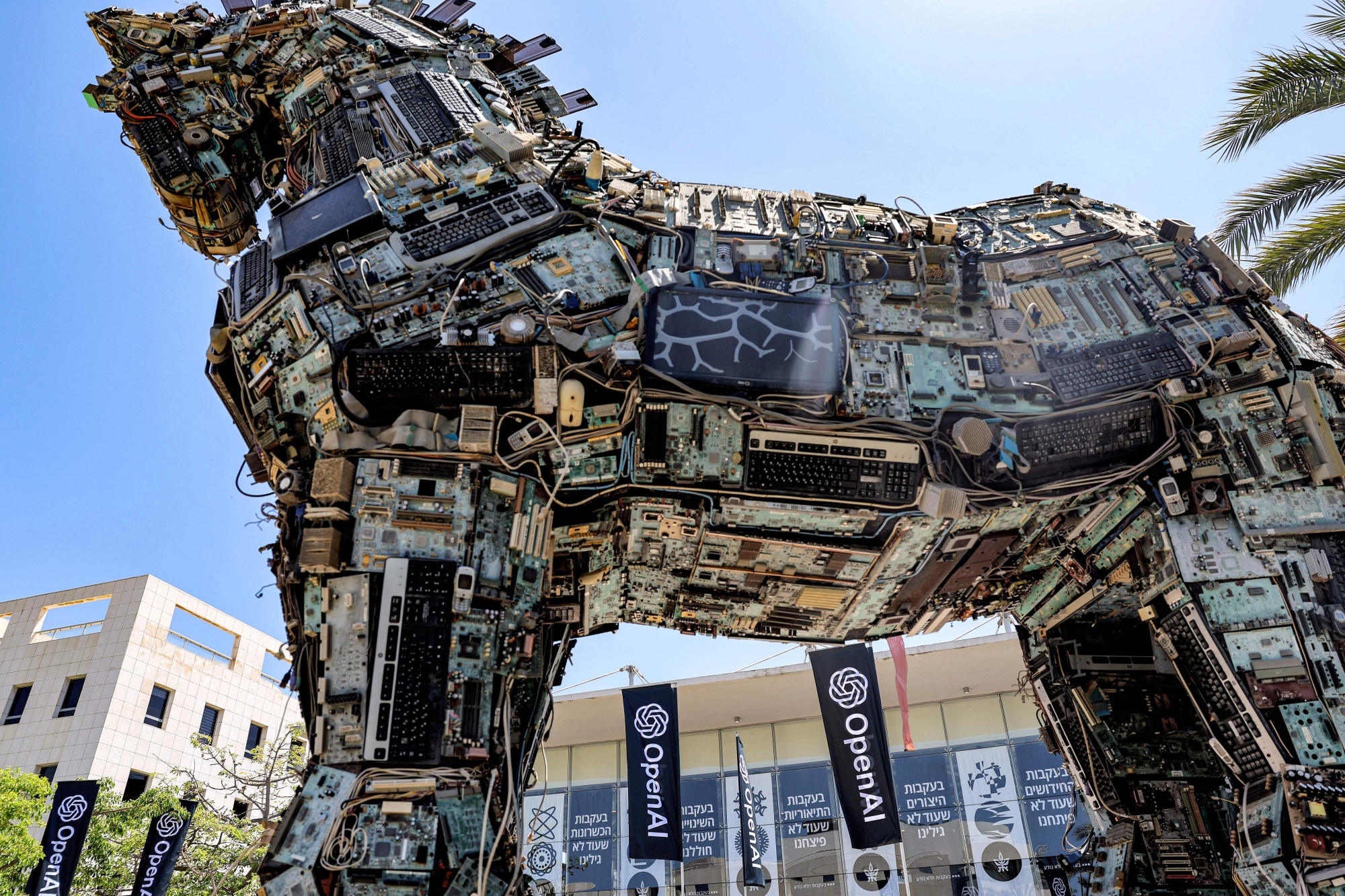

加油,@sama。

加油,@sama。

摄影师:杰克·盖兹/法新社/盖蒂图片社

两周前,我提出并试图回答六个问题关于人工智能革命的经济和金融后果。今天,我有更多 — 八个 — 政治和地缘政治问题。这些问题更难回答。

1. 人工智能会对2024年的选举产生不利影响吗?

这似乎是非常可能的。因为美国的选举活动拥有比其他发达国家更大的竞选预算,每一项新的通讯技术都会被政治企业家迅速采用。想想谷歌在2012年为奥巴马总统竞选提供了什么,或者Facebook广告为特朗普竞选提供了什么。在2020年,硅谷通过所谓的内容管理帮助了乔·拜登。

彭博观点特朗普媒体的股价与其业务无关让日食成为你孤独的解药人工智能会制造比揭露更多的假新闻吗?《沙丘2》比福山更好地预测未来像OpenAI的GPT-4这样的大型语言模型(LLMs)具有巨大的政治潜力。它们可以生成大量的似是而非的内容,几乎不需要人类监督。这包括虚假电话和视频剪辑。我们已经看到了第一个虚假电话(模仿拜登的声音)在新罕布什尔州初选中。

很难相信政治上对人工智能的使用将被简单地禁止。

但是,其大规模部署意味着什么呢?最近的研究显示,即使是比GPT-3更不先进的开源LLMs也能够产生被调查对象评为与纽约时报同一主题材料一样可信的内容。一项实验研究表明,人工智能系统可以通过虚假的选民反馈淹没立法者或政府机构。

其他调查显示,即使选民被提醒要警惕深度伪造视频,他们也不会变得更擅长识别深度伪造视频,但他们会失去对真实视频的信任。

所有这些可能意味着选举将产生额外的公共压力来进行监管,特别是如果发现某个竞选活动以恶意方式使用人工智能。

2. 美国是否会通过监管来限制人工智能?

去年十月,拜登发布了一项行政命令,详细说明了他的政府监管人工智能的优先事项。

在其中一个更具约束力的安全规定中,该命令援引了1950年的国防生产法案,要求开发可能威胁国家安全的先进人工智能系统的公司通知联邦政府并报告安全测试或“红队测试”的结果。此要求仅适用于非常庞大的系统(进行超过10的26次方次数的训练运算)。

行政命令不规范公司构建AI模型的责任或要求许可,正如OpenAI首席执行官Sam Altman等人提出的那样。 Altman在五月份向国会作证时呼吁成立一个新的联邦机构来许可AI公司并监督审计。这是不太可能的。

因此,行政命令的可执行性和实施将在很大程度上取决于联邦机构的执行和规则制定,以及司法审查和科技公司遵守新规定的意愿。

联邦贸易委员会主席Lina Khan 在纽约时报中写道,去年五月,她的机构已经对一系列与AI相关的问题具有管辖权,包括竞争和消费者保护。她的文章提出了三个焦点问题:反垄断、欺诈和滥用以及劳工歧视。去年七月,FTC启动了一项调查,以确定OpenAI是否从事与隐私和数据安全相关的“不公平或欺骗性行为”。

在国会中,迄今为止最连贯的提案是美国AI法案的两党框架,由康涅狄格州民主党参议员Rich Blumenthal和密苏里州共和党参议员Josh Hawley赞助。

Hawley-Blumenthal将澄清《通信廉正法》第230条——互联网历史上的一项关键立法——“不适用于AI”,这意味着公司将对传播有害的AI生成内容承担责任。该法案还将要求AI开发者和提供者向用户披露何时与AI系统互动;制定保护儿童的规则;让消费者控制其个人数据在AI系统中的使用方式;要求AI生成的深度伪造内容加水印;并限制向中国转让AI技术。

这项立法会通过吗?可能不会。国会在对新技术进行监管方面有着缓慢的记录。从铁路的发明到第一项联邦监管之间的时间为62年。对于电话是33年;无线电是15年;互联网是13年。核能是个例外:滞后时间仅为四年。

3. 欧洲能成功监管人工智能吗?

欧洲委员会一如既往地希望在人工智能监管方面引领世界。其AI法案将于今年晚些时候正式通过,并且其大部分规定将于2026年生效,该法案规定了数据质量、监督和披露要求。

AI法案将AI系统分为四个级别,取决于它们可能对人类健康、安全和基本权利构成的威胁。每个级别都面临不同的监管要求。包括某些形式的生物特征监视和“社会评分”系统在内的不可接受风险应用被彻底禁止。关键基础设施运营、教育培训、边境检查和执法是被视为“高风险”的AI系统的例子。最低风险的AI系统包括垃圾邮件过滤器,它们只需遵守自愿行为准则。最后,“透明度风险”AI系统,涉及与用户的互动(例如聊天机器人),必须披露其内容是由机器生成的。

欧洲人希望重复他们在在线隐私方面通过《通用数据保护条例》(GDPR)所取得的成就。许多非欧盟国家在其国内市场内采纳了严格的欧洲监管标准,纯粹是因为他们希望将产品销售到欧盟市场。自2018年以来,GDPR监管机构已经处以45亿欧元的罚款,尽管美国的大型科技公司已经通过诉讼进行了反击。

然而,我怀疑欧洲人能否制定AI监管标准。2021年,华盛顿和布鲁塞尔成立了贸易和技术理事会。在这个框架内,他们试图并未能就AI监管的“自愿行为准则”达成一致。欧洲面临的一个大问题是几乎没有任何主要的人工智能公司,法国的Hugging Face是一个明显的例外。

4. 是否存在全球治理体系的前景?

DeepMind的联合创始人(2014年被Google收购)和微软AI的新负责人穆斯塔法·苏莱曼去年提出了一份雄心勃勃的蓝图,旨在建立一个国际“技术审慎”制度来监管这项技术。他和欧亚集团的伊恩·布雷默提出了一个模型,即“全球金融机构(如金融稳定理事会、国际清算银行和国际货币基金组织)发挥的宏观审慎作用”。

我仍然不相信AI可以像金融那样受到监管。然而,布雷默-苏莱曼模型还有另外两个要素。一个是类似于气候变化政府间专门委员会的机构,以确保我们定期进行严格的AI影响评估。另一个是“华盛顿和北京应该致力于创建由第三方提出和监督的共同点和甚至防范措施。在这里,常见于军备控制体制的监测和验证方法可能会被应用。”

人工智能和核武器之间的类比显然并不完美。正如苏莱曼和布雷默自己所承认的:“人工智能系统不仅比核武器更容易开发、窃取和复制;它们由私营公司控制,而不是政府。”然而,他们——就像几乎所有试图系统地思考如何应对人工智能带来的威胁的人一样——又被引导回与冷战军备竞赛的比较。

一个理想的全球治理体系将构建各国之间的协调,以阻止非国家行为者和流氓国家开发或获取尖端人工智能模型。执法将通过全球出口管制制度来实现(针对GPU,即由Nvidia设计、由台积电制造的最复杂的半导体)和云计算的全球了解客户协议。

这样的系统已经在建设中。然而,出于地缘政治原因,它的目标是中国。由于中国是唯一的另一个人工智能超级大国,这显然毫无意义。在他生命的最后一年,亨利·基辛格试图在美国和中国之间建立一场有意义的人工智能军备控制对话。这一举措能够长久存在是值得怀疑的。

历史和最近的事件因此表明,在短期甚至中期内,全球人工智能治理体系是非常不太可能的。我们离人工智能限制谈判的理念还有很长的路要走。因此,军备竞赛将继续以目前的疾驰速度进行。

5. 中国能赶上吗?

回到2021年,由前谷歌CEO埃里克·施密特主持的一个委员会发布了一份报告,预测“中国可能超越美国成为世界人工智能超级大国。” 然而,这似乎并没有发生。最大的中国LLM不及美国领先者。

为什么中国落后?简单的答案是它无法自行制造最复杂的半导体,而美国能够限制其获取由TSMC生产的以及由荷兰公司ASML生产的复杂芯片制造机器。根据我的同事克里斯·米勒的著作芯片战争,“多达95%的中国服务器中运行人工智能工作负载的GPU由Nvidia生产。” 中国可以为自己生产较不花哨的芯片 — 例如,用于电动汽车的芯片。但无法生产AI芯片。

这是否意味着“科技战”已经结束 — 起初是在唐纳德·特朗普总统的政府针对华为和中兴展开,最终在2022年10月商务部对所有中国公司实施限制 — 已经赢了?不要那么快下结论。确实,中国在人工智能支出和人工智能公司成立方面落后于美国。但在机器人领域却领先。中国正在极力寻找绕过美国限制的方法。Nvidia也并非对中国对其芯片的贪婪漠不关心。近年来,来自中国的收入占该公司总收入的五分之一至四分之一。《经济学人》并非唯一怀疑Nvidia芯片是否通过新加坡走私到中国。

美国仍然是人工智能人才的主要市场。但最新一期MacroPolo关于顶尖人工智能研究人员职业生涯的研究 — 那些在2022年12月神经信息处理系统(NeurIPS)会议上被接受论文的人 — 表明北京正在迎头赶上。中国是很大一部分顶尖人工智能研究人员开始他们的学术生涯的地方,2022年达到47%,而2019年为29%。自2019年以来,美国在人工智能就业方面的主导地位已经受到侵蚀,从65%下降到57%。记住:苏联在核武器竞赛中远远落后于美国。它花了20年时间赶上,但最终做到了。

6. AI真的是新的曼哈顿计划吗?

我的科技领主朋友Vinod Khosla和Marc Andreessen上个月就人工智能进行了有趣的交流。两人都是著名的风险投资家。但Khosla是OpenAI的支持者,也是Altman的监管理念的粉丝;而Andreessen更喜欢看到开源模式蓬勃发展。“你会开源曼哈顿计划吗?”Khosla在X(前身为Twitter)的交流中问道。“这对国家安全更为严重。我们正处于与中国的技术经济战中,而AI是必须取胜的。这正是爱国主义的真谛,而不是口号。”

正如我所说,人工智能与核裂变之间的类比远非完美。但有一点对我来说非常引人注目。如今,世界上大约有12,500枚核弹头,而随着中国迅速增加其核武库,这一数字正在上升。相比之下,目前只有436个核反应堆在运行。核能在全球总发电量中所占比例已从1996年的15.5%下降至2022年的8.6%,部分原因是对少数核事故的政治过度反应对人类健康和环境的影响微乎其微。事实上,以绝对值计算,核电发电量在2006年达到峰值。

在考虑人工智能的可能用途时,我们应该记住,作为一个物种,我们有着一部记录。是的,人工智能可以被用于各种美妙的用途。医学科学的可能性尤其令人惊叹。但核裂变的历史表明,我们至少会付出同样多的努力来开发人工智能的破坏潜力。

7. 人工智能世界将需要多少能量?

核裂变和人工智能之间的一个重要区别在于人工智能只会 消耗 能量。但是需要多少呢?一些危言耸听的评论者预测,到2030年,人工智能可能需要接近全球电力产量的四分之一。然而,我迄今阅读过的最彻底的分析(由 Dylan Patel, Daniel Nishball 和 Jeremie Eliahou Ontiveros 撰写,发表在SemiAnalysis上)得出结论称,“到2030年,人工智能将推动数据中心使用全球能源产量的4.5%。”

这仍然是很多。由于很多人工智能活动集中在美国,数据中心“关键” IT容量将需要从2023年到2027年增加两倍,从美国电力产量的4.5%增加到14.6%。

最近几周,美国主流媒体开始意识到这意味着什么,尤其是对于减少由天然气产生的电力份额、增加由“可再生”来源产生的份额的梦想。

那个梦想已经破灭。

8. 人工智能将对战争的未来意味着什么?

安德森在他的人工智能文章中最值得怀疑的断言是,“为什么人工智能将拯救世界”,他声称“人工智能将通过大幅降低战时死亡率来改善战争,因为人工智能将帮助政治家和指挥官们“做出更好的战略和战术决策,最小化风险、错误和不必要的流血。”

我强烈怀疑情况将相反。在即将到来的人工智能战争中,由于人工智能将使导弹和其他武器更加精确,军队的死亡率将非常非常高。这已经在乌克兰显现,那里的无人机战争正在逐渐从远程人驾驶系统过渡到人工智能驱动的自主系统。

我们这个时代的中心问题应该是显而易见的。美国实际上在没有仔细考虑的情况下,将最先进的半导体制造外包给了中国声称拥有主权的一个岛屿。 TSMC的主要原因 —— 该公司生产超过90%的GPU —— 其市盈率仅为14.3的原因是其易受攻击的位置。

引用 华尔街日报,“美中围绕台湾的战争几乎肯定会导致TSMC的晶圆厂被摧毁。这将使全球芯片供应链倒退五到十年,从而破坏人工智能的繁荣。” 再次引用克里斯·米勒的话,“如果台湾的晶圆厂被摧毁,我们在接下来的一年内将生产的计算能力将减少37%。” 即使中国“只是”封锁了台湾,“TSMC的芯片生产也将停止,因为政府会对能源进行配给。”

如果美国能在美国本土建立自己的TSMC版本,那将非常非常好。这个梦想激发了充满补贴的CHIPS法案。

我只能说我 不抱太大希望。

弗格森还是Greenmantle咨询公司、FourWinds Research、Hunting Tower风险投资合作伙伴和电影制片人Chimerica Media的创始人。

更多来自Niall Ferguson在彭博观点的内容:

- 抵抗 是徒劳的,但也许人工智能除外

- 全球人口崩溃 不再是科幻

- 如果你认为第三次世界大战是不可想象的,读一下这篇文章

想要更多彭博观点吗? OPIN <GO> 。或订阅 我们的每日新闻简报**。**